GPT-4o 소개

https://openai.com/index/spring-update/

GPT-4o는 GPT-4 수준의 지능을 제공하면서도 훨씬 빠르고 텍스트, 음성 및 비전 기능 전반에서 성능을 향상시킨 최신 주력 모델입니다.

오늘날 GPT-4o는 공유하는 이미지를 이해하고 논의하는 데 있어 기존의 어떤 모델보다 뛰어납니다. 예를 들어, 이제 다른 언어로 된 메뉴의 사진을 찍고 GPT-4o에게 번역을 요청하거나 음식의 역사와 중요성에 대해 배우고 추천을 받을 수 있습니다. 앞으로의 개선 사항은 더 자연스럽고 실시간 음성 대화가 가능하며 실시간 비디오를 통해 ChatGPT와 대화할 수 있는 기능을 제공할 것입니다. 예를 들어, 실시간 스포츠 경기를 보여주고 규칙을 설명해 달라고 요청할 수 있습니다. 우리는 이러한 새로운 기능을 갖춘 새로운 Voice Mode를 앞으로 몇 주 내에 알파 버전으로 출시할 예정이며, Plus 사용자에게 초기 접근 권한을 제공하며 점차 더 널리 롤아웃할 계획입니다.

고급 AI를 전 세계적으로 더 쉽게 접근하고 유용하게 만들기 위해 GPT-4o의 언어 능력은 품질과 속도 면에서 향상되었습니다. ChatGPT는 이제 가입 및 로그인, 사용자 설정 등에서 50개 이상의 언어를 지원합니다.

우리는 ChatGPT Plus 및 팀 사용자에게 GPT-4o를 롤아웃하기 시작했으며, 곧 엔터프라이즈 사용자에게도 제공될 예정입니다. 오늘부터 사용 한도가 있는 ChatGPT Free에도 롤아웃을 시작합니다. Plus 사용자는 무료 사용자보다 최대 5배 더 많은 메시지 한도를 가지며, 팀 및 엔터프라이즈 사용자는 더욱 높은 한도를 가지게 될 것입니다.

더 많은 지능과 고급 도구를 무료로 제공

우리의 사명은 가능한 많은 사람들에게 고급 AI 도구를 제공하는 것입니다. 매주 1억 명 이상의 사람들이 ChatGPT를 사용하고 있습니다. 앞으로 몇 주 동안 ChatGPT Free 사용자에게 더 많은 지능과 고급 도구를 제공하기 시작할 것입니다.

GPT-4o를 사용할 때, ChatGPT Free 사용자는 이제 다음과 같은 기능에 액세스할 수 있습니다:

- GPT-4 수준의 지능 체험

- 모델과 웹에서 응답 받기

- 데이터 분석 및 차트 생성

- 찍은 사진에 대해 대화하기

- 파일 업로드를 통한 요약, 작성 또는 분석 지원

- GPT와 GPT 스토어 발견 및 사용

- 메모리 기능을 통해 더 유용한 경험 구축

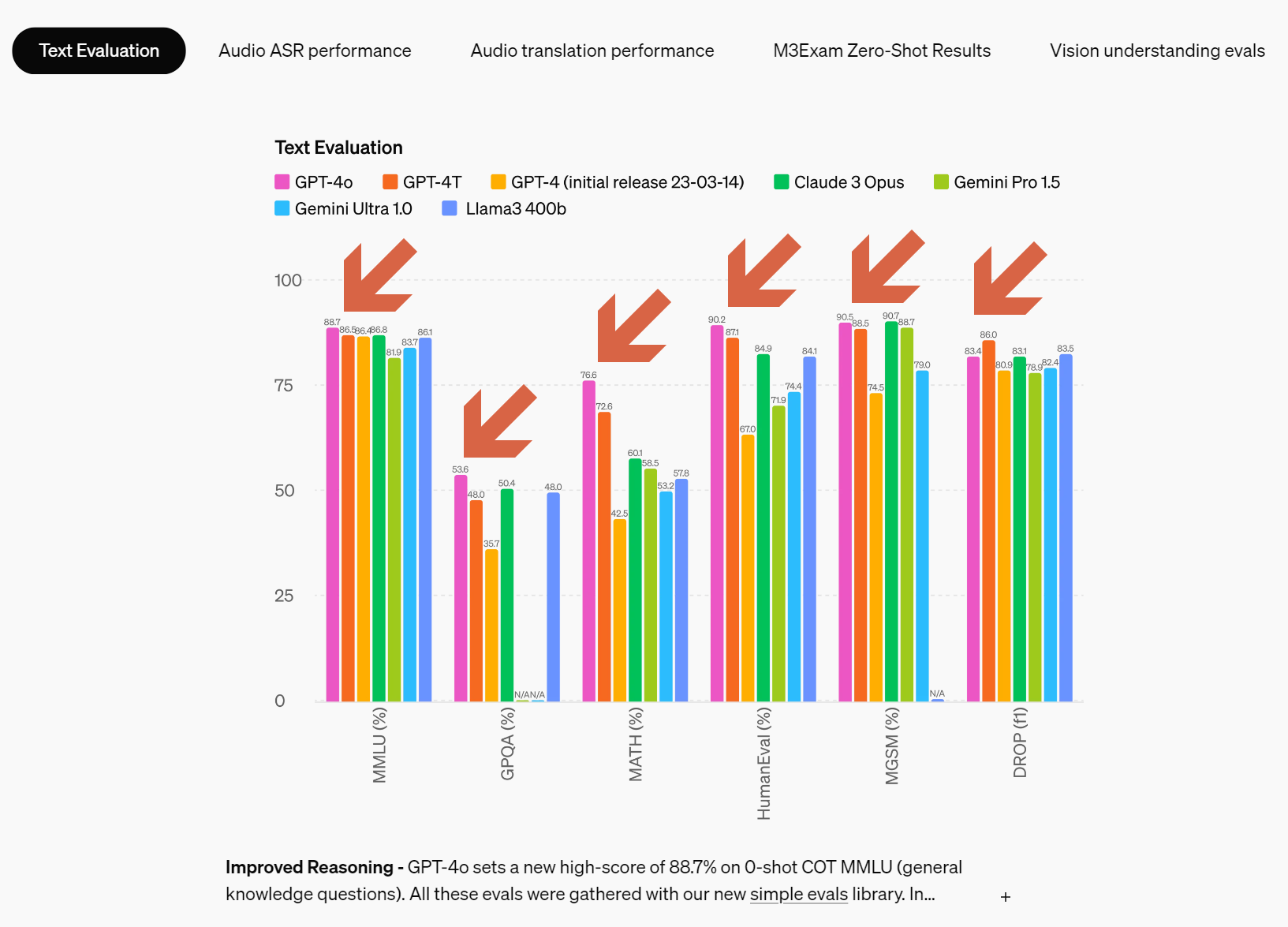

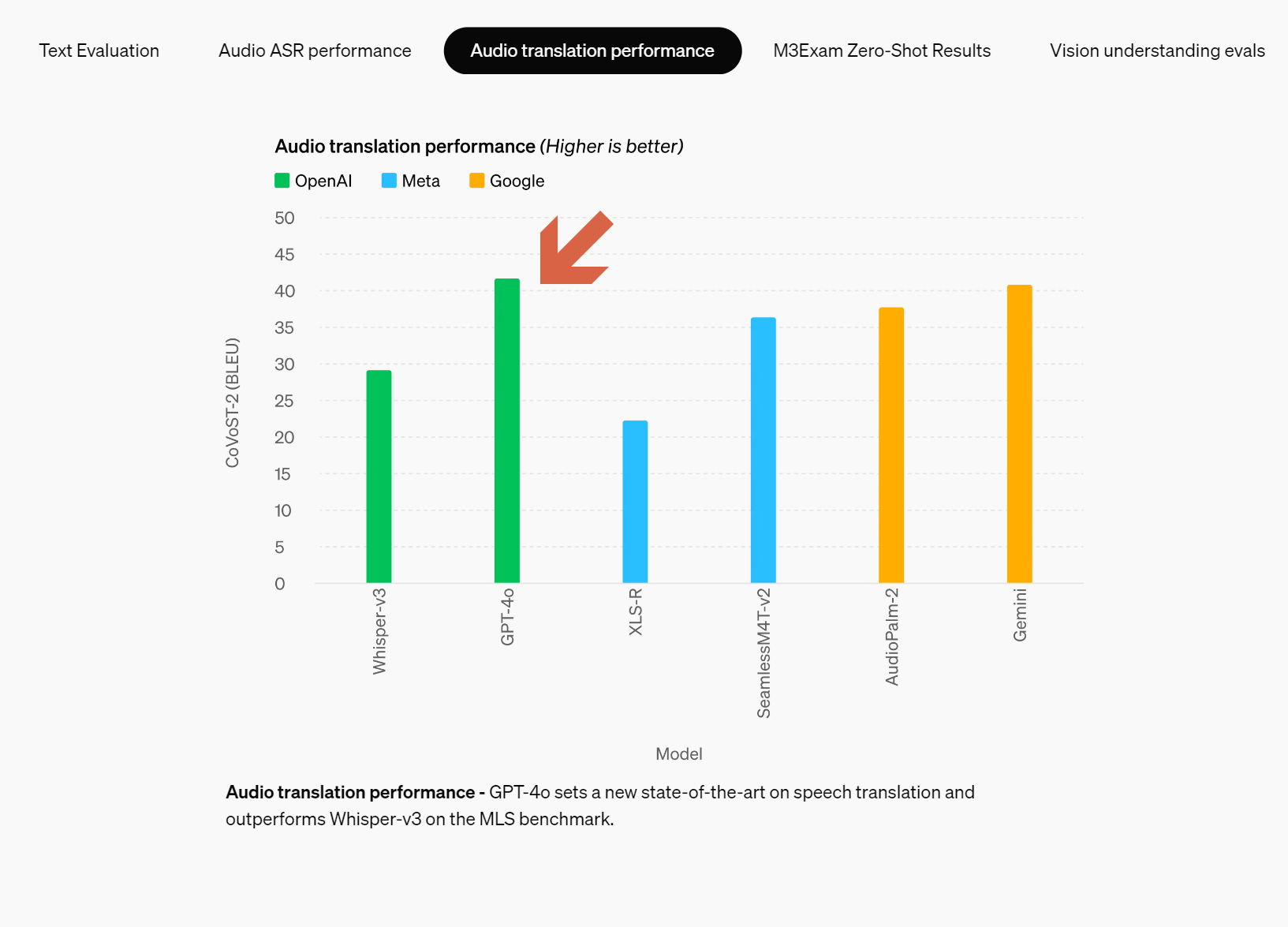

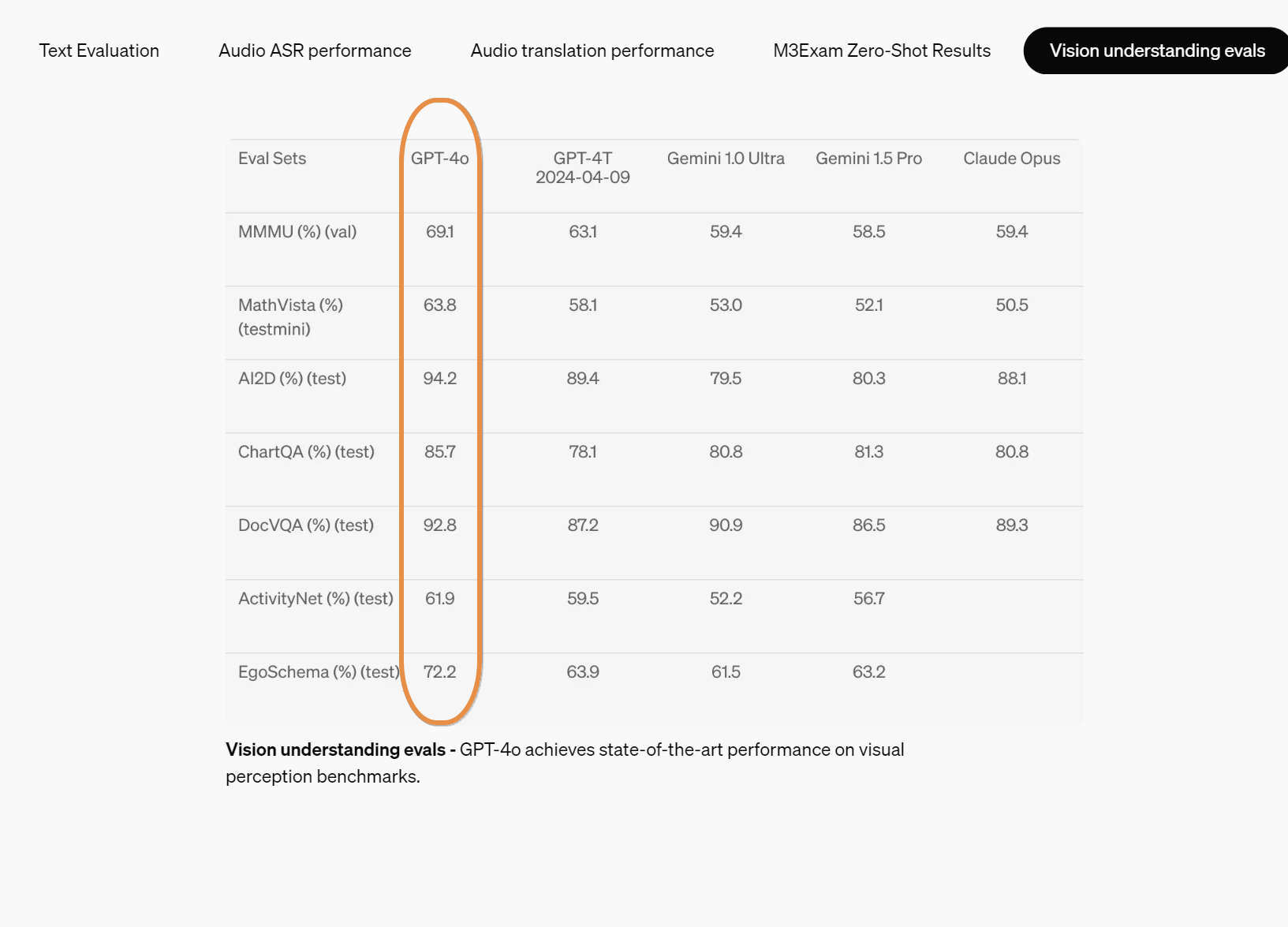

GPT-4o("o"는 "omni"의 약자)는 훨씬 더 자연스러운 인간-컴퓨터 상호 작용을 향한 한 단계입니다. 텍스트, 오디오, 이미지의 조합을 입력으로 받아들이고 텍스트, 오디오, 이미지 출력을 생성할 수 있습니다. 오디오 입력에 232밀리초, 평균 320밀리초만에 응답할 수 있으며, 이는 대화에서 인간의 응답 시간과 유사합니다. 영어 텍스트와 코드에서는 GPT-4 Turbo와 동일한 성능을 보이며, 비영어권 언어의 텍스트에서는 상당한 개선을 이루었습니다. 또한 API에서 훨씬 빠르고 비용이 50% 저렴합니다. GPT-4o는 기존 모델에 비해 비전과 오디오 이해에서 특히 뛰어납니다.

GPT-4o 이전에는 Voice Mode를 사용하여 ChatGPT와 대화할 때 평균 지연 시간이 GPT-3.5는 2.8초, GPT-4는 5.4초였습니다. 이를 위해 Voice Mode는 세 개의 별도 모델로 구성된 파이프라인을 사용했습니다. 첫 번째 간단한 모델은 오디오를 텍스트로 변환하고, GPT-3.5 또는 GPT-4가 텍스트를 입력받아 텍스트를 출력하며, 세 번째 간단한 모델이 그 텍스트를 다시 오디오로 변환합니다. 이 과정에서 주요 지능인 GPT-4는 많은 정보를 잃게 됩니다. 톤, 다중 화자, 배경 소음을 직접 관찰할 수 없으며, 웃음, 노래 또는 감정을 표현할 수 없습니다.

GPT-4o와 함께 우리는 텍스트, 비전, 오디오 전반을 아우르는 단일 새로운 모델을 엔드 투 엔드로 훈련했습니다. 즉, 모든 입력과 출력이 동일한 신경망에 의해 처리됩니다. GPT-4o는 이러한 모든 모달리티를 결합한 최초의 모델이므로, 우리가 모델의 가능성과 한계를 탐구하는 것은 이제 막 시작에 불과합니다.

모델 안전성과 한계

GPT-4o는 여러 모달리티에 걸쳐 설계에 의해 안전성이 내장되어 있으며, 훈련 데이터 필터링 및 훈련 후 모델 행동 개선과 같은 기술을 통해 안전성을 강화했습니다. 또한, 음성 출력에 대한 안전 장치를 제공하기 위해 새로운 안전 시스템을 만들었습니다.

우리는 GPT-4o를 우리의 준비 프레임워크 및 자발적 약속에 따라 평가했습니다. 사이버 보안, CBRN(화학, 생물, 방사선, 핵), 설득력, 모델 자율성에 대한 평가 결과, GPT-4o는 이 모든 범주에서 중간 위험 이상을 기록하지 않았습니다. 이 평가는 모델 훈련 과정 전반에 걸쳐 자동화 및 인간 평가를 통해 수행되었습니다. 모델의 능력을 더 잘 이끌어내기 위해 사전 안전 완화 및 사후 안전 완화 버전을 사용자 정의 미세 조정 및 프롬프트를 사용하여 테스트했습니다.

GPT-4o는 또한 70명 이상의 외부 전문가들이 참여한 광범위한 외부 레드 팀 테스트를 거쳤습니다. 사회 심리학, 편향과 공정성, 잘못된 정보 등의 분야에서 새롭게 추가된 모달리티로 인해 도입되거나 강화된 위험을 식별하기 위해 노력했습니다. 우리는 이러한 학습을 활용하여 GPT-4o와 상호 작용하는 안전성을 향상시키기 위한 안전 개입을 구축했습니다. 새로운 위험이 발견될 때마다 이를 완화하기 위해 계속 노력할 것입니다.

GPT-4o의 오디오 모달리티가 다양한 새로운 위험을 제기한다는 점을 인식하고 있습니다. 오늘 우리는 텍스트 및 이미지 입력과 텍스트 출력을 공개적으로 출시합니다. 앞으로 몇 주 및 몇 달 동안 기술 인프라, 훈련 후 사용성, 그리고 다른 모달리티를 출시하는 데 필요한 안전성을 작업할 예정입니다. 예를 들어, 출시 시 오디오 출력은 미리 설정된 목소리 선택에 제한되며 기존 안전 정책을 준수할 것입니다. GPT-4o의 모든 모달리티 범위를 다루는 자세한 내용을 향후 시스템 카드에서 공유할 예정입니다.

모델의 테스트와 반복 작업을 통해 모든 모달리티에 걸쳐 몇 가지 한계가 있음을 관찰했습니다. 아래에 그 중 몇 가지를 예시로 설명합니다.

'배움: MBA, English, 운동' 카테고리의 다른 글

| 고요한 비행체 (UAM), 내년 말 서울 상공에 (1) | 2024.05.14 |

|---|---|

| K방산 수출, 최초로 200억 달러 달성 전망 (0) | 2024.05.14 |

| 한반도 상공 위성 감시 및 우주 방어 체계 현황 (0) | 2024.05.13 |

| 아시아 정부, 달러 강세에 맞서 통화 보호 강화 (0) | 2024.05.13 |

| 소프트뱅크, 인공지능 칩 시장에 진출 - 손정의의 AI 전략 (0) | 2024.05.12 |