2024년 9월 25일

경량 및 멀티모달 라마 모델 소개

주요 내용:

- 오늘, 우리는 라마 3.2를 출시하며, 여기에는 소형 및 중형 비전 LLM(11B 및 90B)과 엣지 및 모바일 장치에 맞는 경량 텍스트 전용 모델(1B 및 3B)이 포함되며, 사전 훈련된 버전과 지침 조정된 버전도 제공됩니다.

- 라마 3.2의 1B 및 3B 모델은 128K 토큰의 문맥 길이를 지원하며, 요약, 지시사항 수행, 로컬 엣지에서 실행되는 재작성 작업과 같은 온디바이스(장치 내) 사용 사례에서 동급 최고의 성능을 발휘합니다. 이 모델들은 퀄컴(Qualcomm)과 미디어텍(MediaTek) 하드웨어에서 첫날부터 사용 가능하며, Arm 프로세서에 최적화되었습니다.

- 광범위한 에코시스템의 지원을 받는 라마 3.2의 11B 및 90B 비전 모델은 해당 텍스트 모델을 그대로 대체할 수 있으며, 이미지 이해 작업에서 Claude 3 Haiku와 같은 폐쇄형 모델을 능가합니다. 다른 개방형 멀티모달 모델과 달리 사전 훈련된 모델과 조정된 모델 모두 맞춤형 애플리케이션을 위해 미세 조정이 가능하며, torchtune을 사용하여 로컬에서 배포할 수 있습니다. torchchat을 통해서도 시도할 수 있으며, Meta AI의 스마트 어시스턴트를 통해 사용할 수 있습니다.

- 우리는 Llama Stack의 첫 번째 공식 배포판을 공유하고 있으며, 이를 통해 개발자가 단일 노드, 온프레미스, 클라우드 및 온디바이스 환경에서 라마 모델을 보다 간편하게 작업할 수 있도록 하고, 통합 안전성이 보장된 RAG(검색 기반 생성) 및 툴링 기반 애플리케이션의 간편한 배포를 가능하게 합니다.

- 우리는 AWS, Databricks, Dell Technologies, Fireworks, Infosys, Together AI와 같은 파트너들과 협력하여 그들의 다운스트림 엔터프라이즈 클라이언트를 위한 Llama Stack 배포판을 구축했습니다. 온디바이스 배포는 PyTorch ExecuTorch를 통해, 단일 노드 배포는 Ollama를 통해 이루어집니다.

- 우리는 개방성이 혁신을 이끌고 개발자, 메타, 나아가 전 세계에 이롭다고 믿기 때문에 우리의 연구를 공유하고 있습니다. 라마는 이미 개방성, 수정 가능성, 비용 효율성 측면에서 선도적인 모델로 자리 잡았으며, 더 많은 사람들이 창의적이고 유용하며 인생을 변화시키는 AI 활용의 돌파구를 열 수 있도록 지원하고 있습니다.

- 우리는 Llama 3.2 모델을 llama.com과 Hugging Face에서 다운로드할 수 있게 했으며, AWS, Databricks, Dell, Google Cloud, Groq, IBM, Intel, Microsoft Azure, NVIDIA, Oracle Cloud, Snowflake 등 파트너 플랫폼의 광범위한 에코시스템에서 즉시 개발이 가능합니다.

우리는 라마 3.1 모델들이 발표된 지 두 달 만에 놀라운 성과를 거두었다는 점에서 매우 기쁩니다. 이 모델들 중 405B는 최초의 개방형 프론티어급 AI 모델이었습니다. 이러한 모델들은 매우 강력하지만, 이를 활용하는 데에는 상당한 컴퓨팅 자원과 전문 지식이 필요합니다. 이에 접근할 수 없는 개발자들이 라마를 사용해보고 싶어 한다는 이야기를 많이 들었습니다. 오늘 Meta의 창립자이자 CEO인 마크 저커버그는 Connect 행사에서, 이제 그들이 더 이상 기다릴 필요가 없다고 발표했습니다. 오늘 발표한 Llama 3.2에는 소형 및 중형 비전 LLM(11B 및 90B)과 엣지 및 모바일 장치에 맞는 경량 텍스트 전용 모델(1B 및 3B)이 포함되어 있습니다.

라마가 발표된 지 1년 반밖에 되지 않았지만, 우리는 엄청난 발전을 이루었습니다. 올해 라마는 10배의 성장을 달성했으며, 책임 있는 혁신의 표준으로 자리잡았습니다. 라마는 개방성, 수정 가능성, 비용 효율성 측면에서 계속 선두를 달리고 있으며, 폐쇄형 모델들과 경쟁할 뿐만 아니라 일부 영역에서는 선두를 달리고 있습니다. 우리는 개방성이 혁신을 이끄는 올바른 길이라고 믿기 때문에 계속해서 연구를 공유하고 파트너 및 개발자 커뮤니티와 협력하고 있습니다.

라마 3.2 모델은 llama.com 및 Hugging Face에서 다운로드 가능하며, AWS, Databricks, Dell, Google Cloud, Groq, IBM, Intel, Microsoft Azure, NVIDIA, Oracle Cloud, Snowflake 등 25개 이상의 파트너들과 협력하여 즉시 사용할 수 있도록 지원합니다. 이 릴리스에서 우리는 Arm, MediaTek, Qualcomm과 협력하여 다양한 서비스를 제공합니다. 오늘부터 우리는 Llama Stack을 커뮤니티에 공개합니다. 최신 릴리스에 대한 자세한 내용과 유럽에서의 멀티모달 사용 가능성에 대한 정보는 우리의 허용 사용 정책에서 확인할 수 있습니다.

Llama 3.2 모델 소개

Llama 3.2의 가장 큰 두 가지 모델인 11B와 90B는 차트 및 그래프를 포함한 문서 수준의 이해, 이미지 캡션 작성, 방향을 묘사한 자연어 설명을 바탕으로 이미지에서 객체를 식별하는 시각적 근거 작업 등 이미지 추론 사용 사례를 지원합니다. 예를 들어, 사용자가 지난 해의 어느 달에 작은 사업체의 판매 실적이 가장 좋았는지 묻는다면, Llama 3.2는 그래프를 기반으로 빠르게 답을 제공할 수 있습니다. 또 다른 예로는, 지도에서 하이킹 경로가 언제 더 가팔라지는지 또는 특정 경로의 거리를 추정하는 데 도움을 줄 수 있습니다. 11B와 90B 모델은 또한 시각적 장면을 이해하고, 이미지를 설명하는 문장을 작성해 이야기를 전달할 수 있도록 도와줍니다.

경량 1B와 3B 모델은 다국어 텍스트 생성 및 도구 호출 기능이 매우 뛰어납니다. 이 모델들은 온디바이스에서 데이터가 장치 외부로 나가지 않도록 하면서 강력한 개인정보 보호 기능을 갖춘 맞춤형 애플리케이션을 구축할 수 있게 합니다. 예를 들어, 이러한 애플리케이션은 마지막으로 받은 10개의 메시지를 요약하고, 실행 항목을 추출하며, 도구 호출을 통해 팔로우업 회의를 위한 일정 초대를 직접 보낼 수 있습니다.

이러한 모델을 로컬에서 실행하면 두 가지 주요 이점이 있습니다. 첫째, 로컬에서 처리되기 때문에 프롬프트와 응답이 즉각적으로 느껴질 수 있습니다. 둘째, 로컬에서 모델을 실행하면 메시지 및 일정 정보와 같은 데이터가 클라우드로 전송되지 않아 애플리케이션의 전체적인 개인정보 보호가 향상됩니다. 로컬에서 처리되기 때문에 애플리케이션은 어떤 쿼리가 장치에 남아야 하고 어떤 쿼리가 클라우드의 더 큰 모델에서 처리되어야 하는지를 명확하게 제어할 수 있습니다.

모델 평가

우리의 평가에 따르면 Llama 3.2 비전 모델은 이미지 인식 및 다양한 시각적 이해 작업에서 Claude 3 Haiku 및 GPT4o-mini와 같은 주요 기초 모델과 경쟁할 수 있습니다. 3B 모델은 지침 수행, 요약, 프롬프트 재작성, 도구 사용 작업에서 Gemma 2 2.6B 및 Phi 3.5-mini 모델을 능가하며, 1B는 Gemma와 경쟁할 수 있습니다.

150개 이상의 벤치마크 데이터셋을 사용하여 다양한 언어에 걸쳐 성능을 평가했습니다. 비전 LLM의 경우 이미지 이해 및 시각적 추론 벤치마크에 대한 성능을 평가했습니다.

비전 모델

비전 작업을 지원하는 최초의 라마 모델인 11B 및 90B 모델은 완전히 새로운 모델 아키텍처를 필요로 했으며, 이미지 추론 작업을 지원합니다.

이미지 입력 지원을 추가하기 위해, 우리는 사전 훈련된 이미지 인코더를 사전 훈련된 언어 모델에 통합하는 어댑터 가중치 세트를 훈련했습니다. 어댑터는 일련의 교차 주의(attention) 레이어로 구성되어 있으며, 이미지 인코더 표현을 언어 모델에 입력합니다. 어댑터 훈련은 텍스트-이미지 쌍을 사용하여 이미지 표현을 언어 표현과 정렬시키는 방식으로 진행되었습니다. 어댑터 훈련 중, 우리는 이미지 인코더의 파라미터를 업데이트했지만, 의도적으로 언어 모델의 파라미터는 업데이트하지 않았습니다. 이를 통해 텍스트 전용 기능을 유지하면서도 Llama 3.1 모델을 그대로 대체할 수 있게 했습니다.

우리의 훈련 파이프라인은 사전 훈련된 Llama 3.1 텍스트 모델에서 시작되는 여러 단계로 구성됩니다. 먼저 이미지 어댑터 및 인코더를 추가한 후, 대규모의 노이즈가 섞인 텍스트-이미지 쌍 데이터를 사용하여 사전 훈련을 실시했습니다. 다음으로, 중간 규모의 고품질 인도메인 및 지식 강화된 텍스트-이미지 쌍 데이터를 사용하여 훈련했습니다.

후훈련에서는 텍스트 모델과 유사한 방법을 사용하여 여러 라운드의 정렬(align)을 수행하고, 지도학습 미세 조정(SFT), 거절 샘플링(rejection sampling), 직접 선호 최적화(DPO)를 반복했습니다. 우리는 Llama 3.1 모델을 사용하여 인도메인 이미지를 기반으로 질문과 답변을 생성하고, 보상 모델을 사용하여 후보 답변을 평가하고 고품질의 미세 조정 데이터를 생성했습니다. 또한 안전성 완화 데이터를 추가하여 안전성을 높이면서도 모델의 유용성을 유지했습니다.

그 결과, 이미지와 텍스트 프롬프트를 모두 받아들이고, 이를 결합하여 깊이 이해하고 추론할 수 있는 모델이 완성되었습니다. 이는 라마 모델이 더욱 풍부한 능력을 갖추는 또 다른 단계입니다.

경량 모델

라마 3.1에서 이야기한 것처럼, 강력한 교사 모델을 활용하여 성능이 향상된 소형 모델을 만들 수 있습니다. 우리는 1B 및 3B 모델에 대해 가지치기(pruning)와 지식 증류(distillation)를 사용하여, 장치 내에서 효율적으로 실행할 수 있는 최초의 매우 유능한 경량 라마 모델을 만들었습니다.

가지는 기존 라마 모델의 일부를 제거하고, 가중치와 기울기의 크기를 조정하여 성능을 유지하면서도 보다 효율적인 소형 모델을 만드는 방식입니다. 1B 및 3B 모델에 대해서는 Llama 3.1 8B 모델에서 체계적으로 네트워크의 일부를 제거하고, 남은 부분의 가중치 및 기울기를 조정하는 방법을 사용하여 성능을 유지했습니다.

지식 증류는 큰 네트워크가 작은 네트워크에 지식을 전수하는 방법으로, 작은 모델이 교사를 통해 스스로 학습하는 것보다 더 나은 성능을 발휘할 수 있게 합니다. Llama 3.2의 1B 및 3B 모델에서는 Llama 3.1 8B 및 70B 모델에서 생성된 로짓을 사전 훈련 단계에서 작은 모델의 토큰 수준 목표로 사용했습니다. 가지치기 후에 지식 증류를 사용하여 성능을 회복했습니다.

후훈련 단계에서는 Llama 3.1과 유사한 방법으로, 지도 학습 미세 조정(SFT), 거절 샘플링(RS), 직접 선호 최적화(DPO)를 여러 라운드 반복하여 최종 채팅 모델을 생성했습니다. 각 라운드는 고품질의 요약, 재작성, 지침 수행, 언어 추론 및 도구 사용과 같은 기능을 최적화하기 위해 데이터를 신중하게 혼합하여 이루어졌습니다.

우리는 128K 토큰의 문맥 길이를 지원하면서도 사전 훈련된 모델과 동일한 품질을 유지하도록 후훈련을 진행했습니다. 또한 신중한 데이터 처리 및 필터링을 통해 생성된 합성 데이터를 활용하여 고품질을 보장했습니다.

Llama Stack 배포

7월에 우리는 Llama Stack API에 대한 의견을 요청했고, 이는 도구 체인 구성 요소(미세 조정, 합성 데이터 생성 등)를 표준화된 인터페이스로 제공하여 라마 모델을 맞춤화하고 능동적 애플리케이션을 구축할 수 있도록 한 것입니다. 많은 참여가 있었습니다.

그 이후 우리는 API의 참조 구현을 구축했습니다. 추론, 도구 사용 및 검색 기반 생성(RAG)에 대한 API를 구현했으며, 파트너들과 협력하여 이를 적응시켜 API 공급자가 될 수 있도록 했습니다. 마지막으로, 여러 API 공급자를 묶어 하나의 엔드포인트를 제공하는 방식으로 Llama Stack Distribution을 도입했습니다. 이제 우리는 단일 노드, 온프레미스, 클라우드 및 온디바이스 환경에서 Llama 모델을 간단하고 일관되게 작업할 수 있는 환경을 커뮤니티에 제공하고 있습니다.

릴리스된 전체 세트는 다음과 같습니다:

- Llama CLI(명령줄 인터페이스)로 Llama Stack 배포판을 빌드, 구성 및 실행

- 파이썬, 노드, 코틀린, 스위프트 등 다양한 언어로 작성된 클라이언트 코드

- Llama Stack 배포 서버 및 에이전트 API 공급자를 위한 Docker 컨테이너

- 여러 배포판

- Meta 내부 구현 및 Ollama를 통한 단일 노드 Llama Stack 배포

- AWS, Databricks, Fireworks, Together를 통한 클라우드 Llama Stack 배포

- PyTorch ExecuTorch를 통한 iOS의 온디바이스 Llama Stack 배포

- Dell을 통한 온프레미스 Llama Stack 배포

우리는 Llama 모델을 사용한 모든 측면을 간소화하기 위해 개발자 및 파트너들과 협력하길 기대하며, 피드백을 환영합니다.

시스템 수준의 안전성

개방형 접근 방식은 많은 이점이 있습니다. 이를 통해 전 세계의 더 많은 사람들이 AI가 제공하는 기회를 누릴 수 있도록 하고, 소수에게만 힘이 집중되는 것을 방지하며, 기술을 보다 공정하고 안전하게 사회에 배포할 수 있게 합니다. 우리는 지속적으로 혁신하는 동시에, 개발자가 안전하고 책임감 있게 시스템을 구축할 수 있도록 지원하고자 합니다.

이전 릴리스와 책임 있는 혁신을 지원하기 위한 지속적인 노력에 기반하여, 오늘 우리는 새로운 업데이트를 추가했습니다:

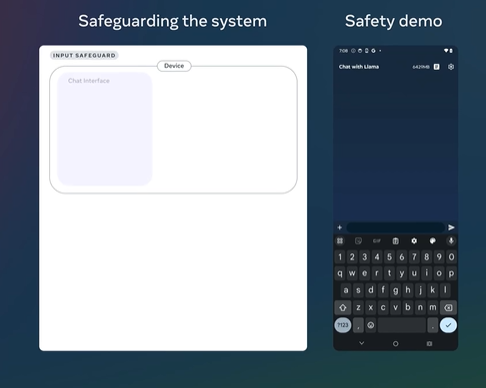

첫째, 우리는 Llama 3.2의 새로운 이미지 이해 기능을 지원하는 Llama Guard 3 11B Vision을 출시했습니다. 이 모델은 텍스트+이미지 입력 프롬프트나 이러한 프롬프트에 대한 텍스트 출력 응답을 필터링하도록 설계되었습니다.

둘째, 1B 및 3B Llama 모델이 온디바이스와 같은 보다 제한된 환경에서 사용되기 때문에, 우리는 Llama Guard를 최적화하여 배포 비용을 크게 줄였습니다. Llama Guard 3 1B는 Llama 3.2 1B 모델을 기반으로 하며, 크기가 2,858MB에서 438MB로 줄어들어 배포가 더욱 효율적으로 이루어질 수 있습니다.

이러한 새로운 솔루션은 우리의 참조 구현, 데모 및 애플리케이션에 통합되었으며, 오픈 소스 커뮤니티에서 첫날부터 사용할 수 있도록 준비되었습니다.

Llama 3.2 체험하기

Llama 3.2는 그 어느 때보다 많은 사람들에게 다가갈 준비가 되어 있으며, 흥미로운 새로운 사용 사례를 가능하게 할 것입니다. 우리는 이러한 모델을 오픈 소스 커뮤니티와 공유하는 것만으로는 충분하지 않다고 생각합니다. 개발자들이 Llama를 책임감 있게 사용할 수 있도록 새로운 도구와 리소스도 제공합니다. 계속해서 책임 있는 사용 가이드의 모범 사례를 업데이트할 예정입니다.

우리는 개방성이 혁신을 이끌고 개발자, 메타, 나아가 전 세계에 이롭다고 믿기 때문에 Llama 생태계에서 최신 발전 사항을 공유하고 있습니다. 파트너 및 오픈 소스 커뮤니티와의 대화를 계속 이어나갈 것이며, Llama 3.2와 Llama Stack을 사용해 커뮤니티에서 어떤 혁신이 일어날지 기대하고 있습니다.

Llama 3.2

The open source AI model you can fine-tune, distill and deploy anywhere. Our latest models are available in 8B, 70B, and 405B variants.

www.llama.com

https://huggingface.co/meta-llama

meta-llama (Meta Llama)

The Llama Family From Meta Welcome to the official Hugging Face organization for Llama, Llama Guard, and Prompt Guard models from Meta! In order to access models here, please visit a repo of one of the three families and accept the license terms and accept

huggingface.co

'배움: MBA, English, 운동' 카테고리의 다른 글

| ChatGPT 활용 - AI 음성 모드 (19) | 2024.09.27 |

|---|---|

| 중국의 최신 핵잠수함 침몰 (17) | 2024.09.27 |

| OpenAI, 영리 기업으로 전환 계획 발표 (15) | 2024.09.26 |

| 미군, 태평양에서 군사적 취약점 해결: 공급선 강화 (15) | 2024.09.25 |

| 디지털 시대의 불길: ‘콘텐츠 함정’이 주는 교훈 (The Content Trap) (26) | 2024.09.24 |