🔍 뉴스 한눈에 보기 (Key Takeaway)

**엔비디아**가 AI 추론(Inference) 특화 반도체 스타트업 **Groq**의 기술을 비독점(non-exclusive) 방식으로 라이선스 확보했다.

동시에 Groq 창업자이자 CEO인 **Jonathan Ross**를 포함한 핵심 인력 일부가 엔비디아로 합류한다.

이 거래는 단순한 인수나 인재 영입이 아니라, AI 반도체 시장의 무게중심이 ‘학습(Training)’에서 ‘추론(Inference)’으로 이동하고 있음을 상징적으로 보여주는 사건이다.

🧠 왜 ‘추론(Inference)’가 핵심인가?

AI 산업 초기에는 대규모 모델을 학습시키는 Training이 중심이었다. 그러나 현재는 다음 단계로 진입했다.

- ChatGPT, Copilot, 검색·추천·번역 등 실제 서비스 트래픽 급증

- 하루 수십억 건의 요청을 처리하는 실시간 응답 처리

- 전력·냉각·운영 비용이 핵심 경쟁력으로 부상

👉 결과적으로 **“얼마나 빠르고, 얼마나 적은 전력으로, 얼마나 많은 요청을 처리하느냐”**가 AI 인프라의 승부처가 되었다.

1) Training은 ‘대형 이벤트’, Inference는 ‘매일 벌어지는 일상’ 🔁

- Training: 모델을 한 번(혹은 가끔) 크게 학습시키는 작업

- 대규모 GPU 클러스터를 특정 기간 집중적으로 사용

- “한 번 만들면 끝”은 아니지만 주기가 상대적으로 길고 계획 가능

- Inference: 사용자가 질문/요청할 때마다 모델이 답을 생성하는 과정

- 하루 24시간, 초 단위로 호출이 발생

- 트래픽이 늘수록 비용·전력·지연시간이 선형 또는 그 이상으로 증가

즉, 기업 관점에서 **Training은 CAPEX 성격(투자)**이 강하고, **Inference는 OPEX 성격(운영비)**이 강합니다.

AI가 사업화될수록 CFO/COO가 보는 지표는 “정확도”만이 아니라 **단위 요청당 비용(cost per query), 전력 효율, SLA(응답 시간)**로 바뀝니다.

2) 사용자 경험(UX)이 곧 경쟁력: “지연시간(latency)이 브랜드를 만든다” ⏱️

Inference는 결국 체감 속도의 문제입니다.

- 응답이 0.5초 늦어지면: 사용자는 “느리다”고 느낍니다.

- 응답이 불규칙하면: 사용자는 “불안정하다”고 느낍니다.

- 피크 시간에 밀리면: 서비스 장애·이탈로 이어집니다.

따라서 Inference는 단순 연산이 아니라 서비스 품질(SLA)과 직결된 공급망입니다.

“가장 똑똑한 모델”보다 “항상 빠르게 답하는 모델”이 더 큰 가치를 만들 수 있습니다.

3) 전력과 냉각이 ‘성장 제한 조건’이 됐다 ⚡🏭

데이터센터는 이제 “칩을 더 꽂으면 해결”되는 시대가 아닙니다.

- 전력 공급(전력 인입) 한계

- 냉각(공조/수랭) 설비 용량 한계

- 랙당 전력 밀도 증가로 인한 운영 리스크 증가

Inference 트래픽이 커질수록 “GPU를 더 사자”가 아니라, **“전력과 냉각 안에서 처리량을 늘릴 방법은?”**이 됩니다.

이 관점에서 Inference 특화 하드웨어가 급부상합니다.

4) 시장의 방향: “Training은 상위 소수, Inference는 모든 기업” 🌍

Training은 대형 모델을 만드는 소수 플레이어가 주도하지만, Inference는:

- 모든 SaaS 기업

- 모든 고객센터/콜센터

- 모든 제조·물류·금융·보안 시스템

- 모든 개인/기업용 AI 비서

로 확장됩니다. AI가 “누구나 쓰는 도구”가 되면, Inference가 시장 전체의 대부분을 차지하게 됩니다.

그래서 지금 “Inference 최적화”가 AI 반도체 전쟁의 핵심 전선이 되는 것입니다.

⚙️ Groq LPU의 전략적 의미

Groq는 GPU가 아닌 **LPU(Language Processing Unit)**라는 독자적 아키텍처를 설계했다.

Groq LPU의 핵심 특징

- 🧩 메모리 내장 구조 → 데이터 이동 최소화

- ⚡ 저전력·고효율 → GPU 대비 에너지 효율 우수

- ⏱️ 예측 가능한 지연시간(latency) → 실시간 서비스에 최적

- 🏭 빠른 생산·배포 가능성

이는 엔비디아 GPU가 여전히 강점을 가진 Training 영역과는 명확히 구분되는 포지션이다.

1) ‘데이터 이동’ 최소화: 메모리-연산 병목을 줄인다 🧠➡️🧠

Inference에서 성능과 전력의 큰 적은 종종 “연산량”이 아니라 데이터 이동입니다.

- 메모리에서 데이터를 가져오고

- 연산한 뒤 다시 쓰고

- 이 과정이 반복되며 전력과 시간이 크게 소모

Groq는 LPU 설계에서 이런 병목을 줄이는 방향(예: 메모리 접근/이동 최적화)을 강조해 왔고, 그 결과로 **전력 대비 처리량(throughput per watt)**과 지연시간 안정성을 강점으로 내세웁니다.

2) ‘예측 가능한 지연시간’: 실시간 서비스에 유리 ⏱️✅

GPU 기반 추론은 워크로드, 스케줄링, 배치 크기, 메모리 압력에 따라 지연시간이 출렁일 수 있습니다.

반면 Groq가 강조하는 포인트는 **“일정한 속도, 일정한 응답”**에 가깝습니다.

- 고객 응답형 챗봇

- 실시간 추천/탐지

- 금융 리스크·보안 이벤트 분석

- 엣지/현장형 의사결정

같이 “빠름”만큼 “항상 동일하게 빠름”이 중요한 영역에서는, 지연시간의 분산(variance) 자체가 경쟁력입니다.

3) Inference 최적화를 위한 ‘단순함’: 운영 스케일에서 강점 🛠️

대규모 서비스 운영에서 진짜 비용은 칩 가격만이 아닙니다.

- 배포 복잡도

- 오케스트레이션(스케줄링) 비용

- 관측/튜닝/장애 대응 비용

- 성능 예측 실패로 인한 과잉 프로비저닝

Inference 특화 칩은 종종 “최고 성능”보다 운영 예측 가능성에서 승부를 봅니다.

GroqCloud 같은 형태로 “칩을 직접 사지 않고도 추론 서비스를 쓸 수 있게” 만든 접근은, 개발자와 기업이 도입 장벽을 낮추는 전략으로 읽힙니다.

4) 전략적 포지셔닝: GPU를 대체하기보다 ‘틈새를 크게 만든다’ 🎯

현실적으로 Training은 여전히 GPU가 강합니다. Groq도 이 영역을 정면으로 치기보다는:

- Training은 GPU,

- Inference의 일부(특히 실시간/저전력/예측가능성 요구)는 LPU

같은 혼합형 데이터센터 구조를 전제로 시장을 확장해 왔습니다.

따라서 엔비디아가 Groq 기술을 라이선스로 확보했다는 것은, “GPU가 약해졌다”라기보다

**“GPU 제국이 Inference의 다음 파이를 놓치지 않기 위해 다른 체계를 끌어안는 그림”**에 가깝습니다.

🏗️ 엔비디아의 진짜 의도: ‘대체’가 아닌 ‘흡수’

이번 계약은 Groq를 경쟁자로 제거하는 방식이 아니다.

- 비독점 라이선스 → 기술 흡수 + 외부 생태계 유지

- 창업자 합류 → 아키텍처 철학을 내부로 이전

- GroqCloud 독립 운영 → 시장 실험은 계속

즉, 엔비디아는

“Inference 전용 칩을 이기는 대신, 우리 생태계 안에 편입한다” 는 전략을 선택했다.

이는 과거 CPU → GPU → 가속기 전환기마다 반복된 엔비디아의 플랫폼 흡수 전략과 정확히 일치한다.

1️⃣ 인수가 아닌 ‘비독점 라이선스’의 의미

엔비디아는 Groq를 사지 않았습니다. 대신 비독점(non-exclusive) 라이선스를 선택했습니다.

이 선택은 다음을 동시에 만족시킵니다.

- 🔓 기술 접근권 확보: 핵심 아키텍처·설계 철학을 내부에서 활용

- 🧪 외부 실험 유지: Groq는 독립적으로 시장에서 검증을 계속

- 🧠 리스크 분산: 특정 아키텍처에 올인하지 않음

즉, 엔비디아는 “정답을 미리 정하지 않고”, Inference라는 영역 전체를 흡수할 수 있는 옵션을 확보한 셈입니다.

2️⃣ 창업자 합류의 진짜 가치: 코드가 아니라 ‘사고방식’

Groq 창업자 **Jonathan Ross**의 합류는 단순 인재 영입이 아닙니다.

- TPU 설계 경험(구글)

- GPU와 다른 사고체계

- “Inference 중심 설계”라는 철학

반도체 경쟁에서 가장 복제하기 어려운 것은 아키텍처를 설계한 사람의 사고방식입니다.

엔비디아는 기술 문서가 아니라 설계 DNA 자체를 내부로 들여온 것입니다.

3️⃣ “GPU vs LPU”가 아닌 “GPU + X” 전략

이번 협력은 GPU의 약점을 인정했다기보다, GPU의 적용 범위를 명확히 정의한 전략에 가깝습니다.

- Training → 여전히 GPU 중심

- 범용 Inference → GPU + 최적화

- 실시간·저전력·예측 가능한 Inference → 전용 아키텍처 옵션

엔비디아는 이제 단일 칩 기업이 아니라,

👉 **AI 워크로드별 최적 아키텍처를 조합하는 ‘인프라 플랫폼 기업’**으로 이동하고 있습니다.

4️⃣ 생태계 통제의 핵심은 ‘대체 불가능성’

엔비디아의 진짜 강점은 칩 성능이 아니라 다음에 있습니다.

- CUDA 생태계

- 소프트웨어 스택

- 개발자 락인(lock-in)

- 레퍼런스 아키텍처 표준화

Groq 기술은 이 생태계 안으로 들어오는 순간, 독립 경쟁자 → 선택 가능한 내부 옵션으로 성격이 바뀝니다.

이것이 바로 ‘구조적 흡수’입니다.

🔗 빅테크 전반으로 확산되는 ‘라이선스+인재 이동’ 트렌드

최근 AI 업계에서 공통적으로 나타나는 패턴은 다음과 같다.

- 메타 플랫폼스 → Scale AI 투자 + CEO 합류

- 구글 → Character.AI 기술 라이선스 + 핵심 인력 채용

- 마이크로소프트 → Inflection AI와 유사 구조

📌 핵심 메시지

이제 AI 경쟁은 “회사를 사느냐”가 아니라

“기술 + 사람 + 시간”을 가장 빠르게 흡수하느냐의 싸움이다.

1️⃣ 공통 패턴: 기술은 라이선스, 사람은 내부로

최근 대표적 사례를 보면 구조가 매우 유사합니다.

- 메타 플랫폼스

→ Scale AI에 대규모 투자, CEO 영입 - 구글

→ Character.AI 기술 라이선스 + 핵심 인력 채용 - 마이크로소프트

→ Inflection AI와 유사 구조의 계약

📌 공식 요약

- 지분 100% 인수 ❌

- 기술 접근 + 인재 흡수 ⭕

- 시장 검증은 외부에서 계속 ⭕

2️⃣ 왜 M&A가 아니라 이 방식인가?

이 방식이 각광받는 이유는 명확합니다.

① 속도

- 인수 → 실사·규제·통합에 수년

- 라이선스+채용 → 즉시 실행

② 유연성

- 기술 방향이 틀릴 경우, 손실 최소화

- 여러 옵션을 병렬로 유지 가능

③ 규제 리스크 회피

- 반독점·국가 안보 심사 부담 감소

AI 경쟁에서 가장 비싼 자원은 돈이 아니라 시간입니다.

3️⃣ 스타트업에도 유리한 ‘출구 전략’

이 구조는 대기업만 유리한 것이 아닙니다.

- 기술은 계속 시장에서 검증

- 클라우드 서비스(GroqCloud 등) 유지

- 창업자는 더 큰 플랫폼에서 영향력 확대

즉, **완전 매각(exit)**이 아닌 👉 **“영향력 있는 확장(exit without disappearing)”**이라는 새로운 모델입니다.

4️⃣ 산업 구조의 변화: 승자독식 → 생태계 흡수

과거 반도체 경쟁이 “누가 더 빠른 칩을 만드나”였다면, 이제는 **“누가 더 많은 유망 옵션을 생태계 안에 담느냐”**로 바뀌었습니다.

- 단일 챔피언 → 옵션 포트폴리오 보유자

- 기술 경쟁 → 아키텍처 선택권 경쟁

- 성능 → 플랫폼 지배력

엔비디아는 이 변화의 가장 앞줄에 서 있습니다.

📈 엔비디아 주가와 시장 지위에 대한 시사점

- 엔비디아 주가: 연초 대비 +35% 이상 상승

- 여전히 세계 최고 가치 기업 중 하나

- 그러나:

- 구글, 아마존 → 자체 칩

- OpenAI, Meta → 커스텀 AI 가속기 설계

➡️ 이번 Groq 딜은 엔비디아가 ‘절대 강자’에서 ‘전략적 조율자’로 진화하고 있음을 보여주는 사례다.

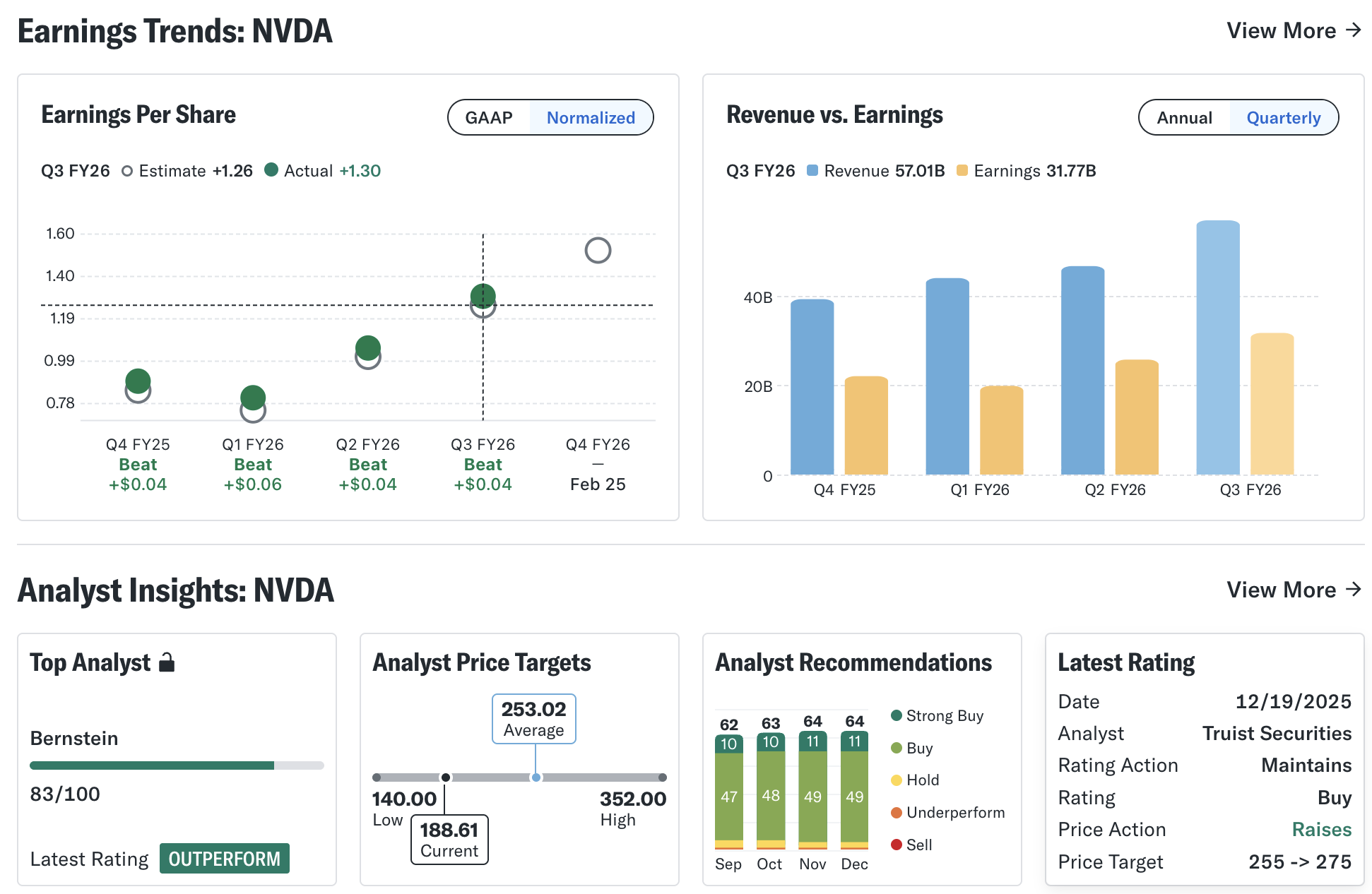

1️⃣ 숫자로 보면: 흔들림은 없다, 아직까지는

객관적인 지표부터 보자.

- 엔비디아 주가: 연초 대비 +35% 이상 상승

- 데이터센터 매출: AI GPU 수요에 힘입어 고성장 지속

- AI 학습(Training) 시장 점유율: 여전히 압도적

즉, 현재 시점에서의 ‘지위 붕괴’는 사실이 아니다.

엔비디아는 여전히 AI 인프라의 핵심 공급자이며, 단기적으로 이를 대체할 플레이어는 보이지 않는다.

2️⃣ 그러나 경쟁의 성격은 달라졌다: “성능 vs 구조”

과거 경쟁은 단순했다.

- 더 빠른 연산

- 더 많은 FLOPS

- 더 큰 GPU 클러스터

하지만 지금의 경쟁은 다르다.

- ⚡ 전력 인입 한계

- ❄️ 냉각 비용 급증

- 💰 단위 추론당 비용(cost per inference)

- ⏱️ 지연시간의 안정성(SLA)

이 영역에서는 GPU가 항상 최적해는 아니다.

그래서 구글, 아마존, 메타, OpenAI 같은 엔비디아의 최대 고객들이 스스로 칩을 설계하기 시작했다.

이는 곧 다음을 의미한다.

👉 엔비디아는 ‘성능 경쟁’에서는 여전히 1위지만, ‘구조 경쟁’에서는 도전받고 있다.

3️⃣ Groq 딜이 보여준 엔비디아의 위기의식

엔비디아가 Groq를 인수하지 않고 라이선스 + 인재 흡수를 선택한 이유는 명확하다.

- Inference 전용 아키텍처가 실제 대안이 될 수 있음을 인정

- GPU 하나로 모든 워크로드를 커버하기 어려운 현실 수용

- 경쟁자를 제거하기보다 옵션으로 흡수

이는 엔비디아가 약해졌다는 신호가 아니라, **“스스로의 한계를 정확히 인식하고 있다는 신호”**에 가깝다.

강자가 무너질 때는 보통 두 가지 패턴이 있다.

- 변화를 무시할 때

- 기존 성공 공식을 고집할 때

엔비디아는 지금 그 반대 방향을 택하고 있다.

4️⃣ 진짜 리스크는 ‘칩’이 아니라 ‘고객’

엔비디아의 가장 큰 리스크는 경쟁 스타트업이 아니다. 바로 자체 칩을 설계하는 고객들이다.

- 구글 → TPU

- 아마존 → Trainium / Inferentia

- 메타 플랫폼스 → 자체 AI 가속기

- 오픈AI → 커스텀 칩 설계 검토

이들은 엔비디아 GPU를 “싫어해서”가 아니라, 규모가 커져서 어쩔 수 없이 자체 설계를 택하고 있다.

👉 이는 엔비디아가 틀렸다는 의미가 아니라,

👉 엔비디아가 너무 커졌다는 의미다.

5️⃣ 그럼에도 엔비디아가 쉽게 무너지지 않는 이유

그럼에도 불구하고 엔비디아의 지위가 쉽게 흔들리지 않는 이유는 명확하다.

- CUDA 중심의 소프트웨어 생태계

- 수백만 개발자 기반

- 레퍼런스 아키텍처와 검증된 안정성

- “지금 당장 쓸 수 있는” 완성도

자체 칩은 **“가능성”**이지만, 엔비디아는 **“즉시 생산성”**을 제공한다. 이 차이는 기업 의사결정에서 매우 크다.

🧭 정리: 이 뉴스가 말해주는 3가지 본질

- **AI의 병목은 이제 추론(Inference)**이다

- 에너지 효율·지연시간·운영 비용이 반도체 경쟁의 핵심 지표가 되었다

- 엔비디아는 경쟁을 제거하지 않고, 구조적으로 흡수하는 방식을 선택했다

AI 반도체 전쟁은 아직 끝나지 않았다. 다만, 전장이 바뀌었을 뿐이다.

엔비디아의 지위는 붕괴되고 있지 않다. 그러나 정체되어 있지도 않다.

지금 엔비디아에서 일어나고 있는 변화는 다음과 같다.

- ❌ “GPU 하나로 모든 AI를 해결한다”

- ⭕ “워크로드별 최적 아키텍처를 조합하는 플랫폼”

Groq 라이선스는 이 전환의 상징이다. 엔비디아는 더 이상 단일 칩 챔피언이 아니라,

👉 AI 인프라의 ‘조율자(Orchestrator)’로 진화하고 있다.

결국 승부를 가를 질문은 이것이다.

“누가 가장 강한 칩을 만드느냐?”가 아니라

“누가 가장 빠르게 변화하는 구조를 설계하느냐?”

현재까지 이 질문에 가장 준비된 회사는, 여전히 엔비디아다.

'배움: MBA, English, 운동' 카테고리의 다른 글

| KAIST 교수가 예측한 AI의 충격적인 미래: 당신이 몰랐던 4가지 사실 (6) | 2025.12.27 |

|---|---|

| 엔비디아가 전부가 아니다? 김학주 교수가 밝힌 AI의 진짜 미래 5가지 (4) | 2025.12.27 |

| 2025 한국 부자보고서로 본 충격적 변화: 돈보다 중요한 것이 바뀌었다 (12) | 2025.12.15 |

| 🚀 Google Antigravity: 에이전트 기반 소프트웨어 개발의 대전환 (3) | 2025.11.20 |

| ✨ 필모라(Filmora) - 동영상 편집 끝판왕 (4) | 2025.11.20 |