1. 도입부: 왜 지금 '피지컬 AI'에 주목해야 하는가?

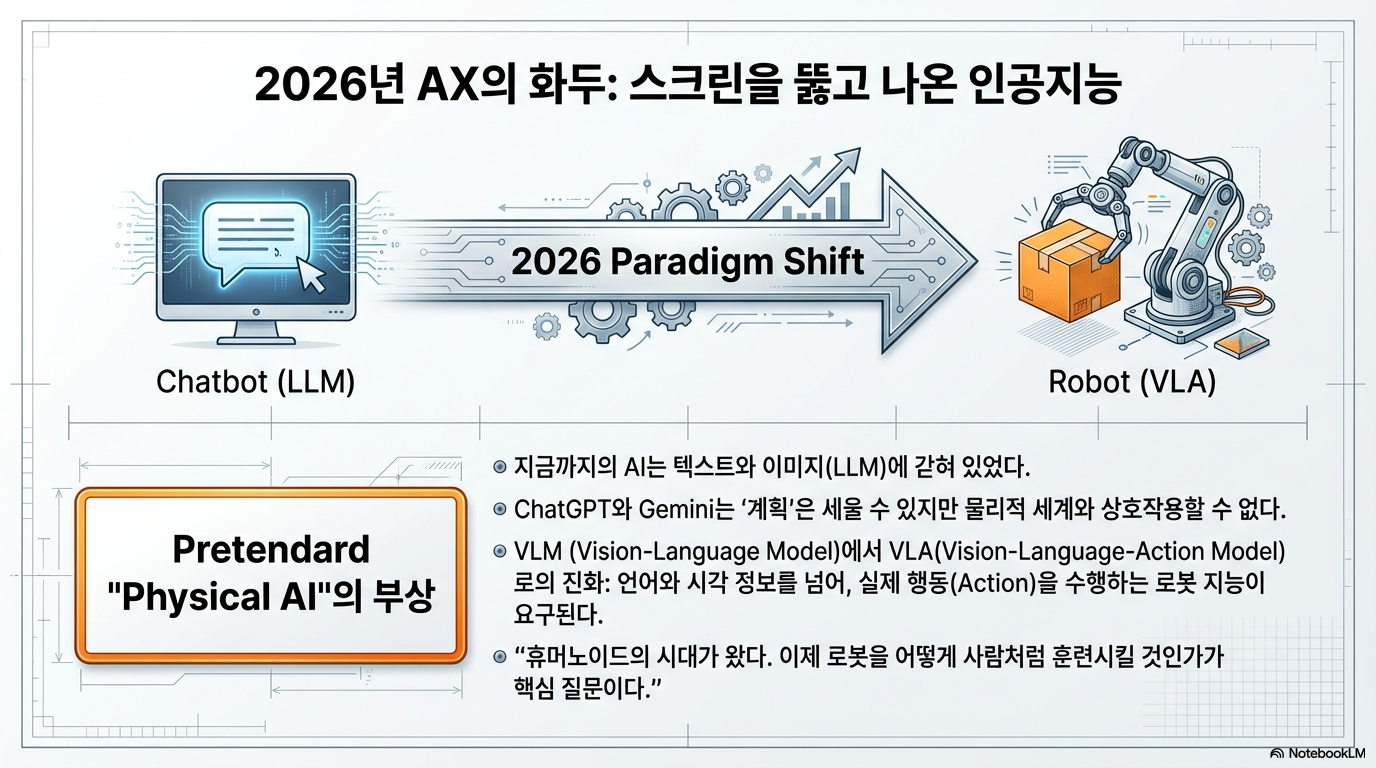

오늘날 모든 기업이 'AI 전환(AX, AI Transformation)'을 외치고 있지만, 대다수 리더에게 그 실체는 여전히 모호합니다. 화면 속의 텍스트와 이미지를 생성하는 수준을 넘어, 이제는 AI가 물리적 실체를 입고 현실 세계와 상호작용하는 '피지컬 AI(Physical AI)'의 시대가 도래하고 있습니다. 2026년 로드맵의 핵심이 될 피지컬 AI는 단순히 기계에 지능을 넣는 것을 넘어, '시멘틱 레이어(Semantic Layer)'와 '키네틱 데이터(Kinetic Data)'를 통해 로봇이 인간의 삶을 재정의하는 과정입니다.

이 변화의 최전선에는 고려대학교 기계공학부 김대겸 교수가 있습니다. 그는 미국 5대 빅테크 기업의 억대 연봉 오퍼와 하버드 대학의 압도적인 연구 인프라를 뒤로하고 한국 귀국을 선택했습니다. 결정적인 계기는 은사님의 한마디였습니다. "인프라가 부족하다면, 너 같은 사람이 한국에 와서 그것을 구축하고 전수하는 교육자 역할을 해야 하지 않겠니?" 이 사명감은 이제 대한민국 로봇 지능의 3단계인 **인지(Perception), 계획(Reasoning), 행동(Action)**을 완성하는 기술적 토대로 이어지고 있습니다.

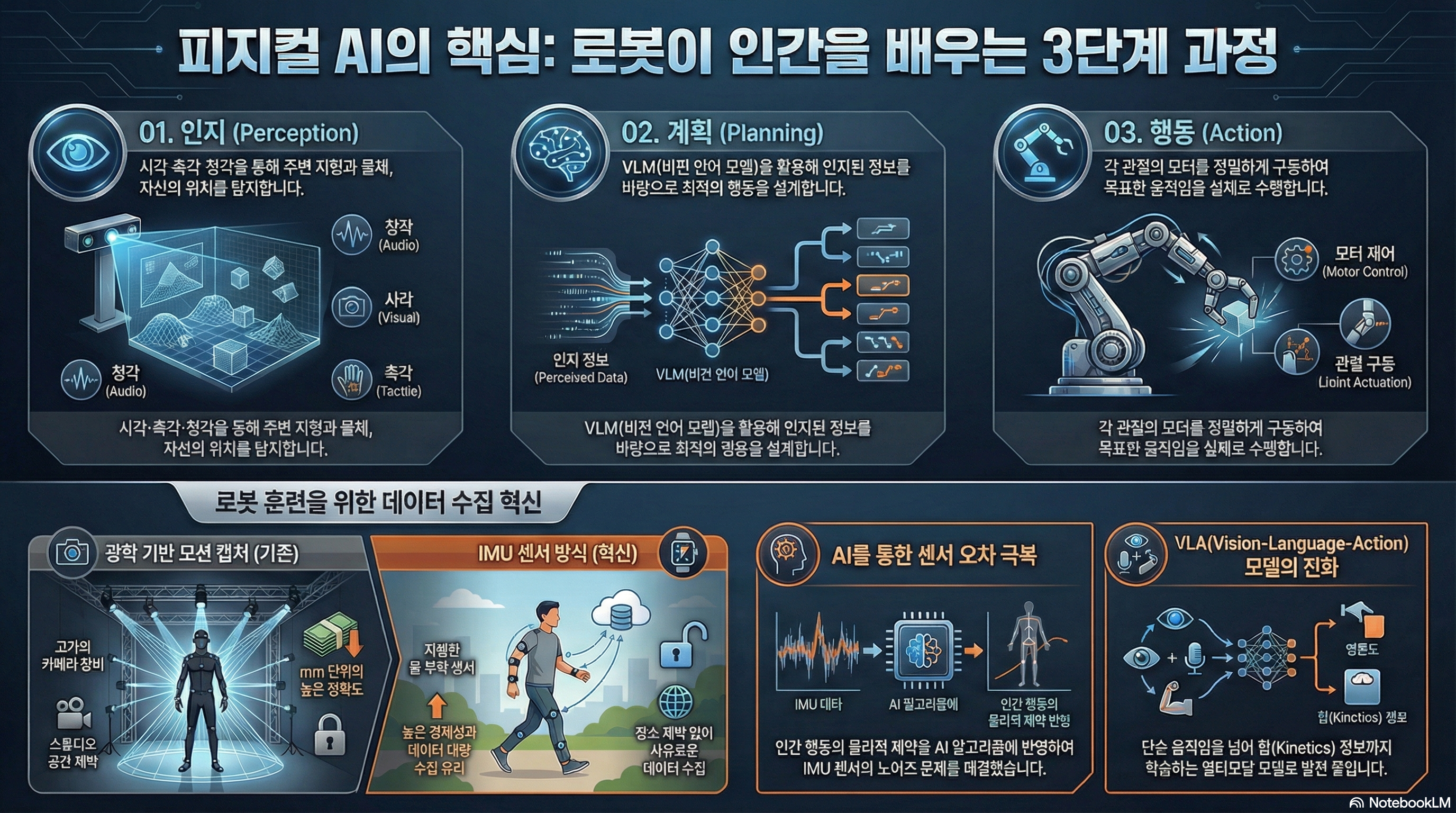

2. [Takeaway 1] 인지-계획-행동: 로봇이 '생각'하는 메커니즘

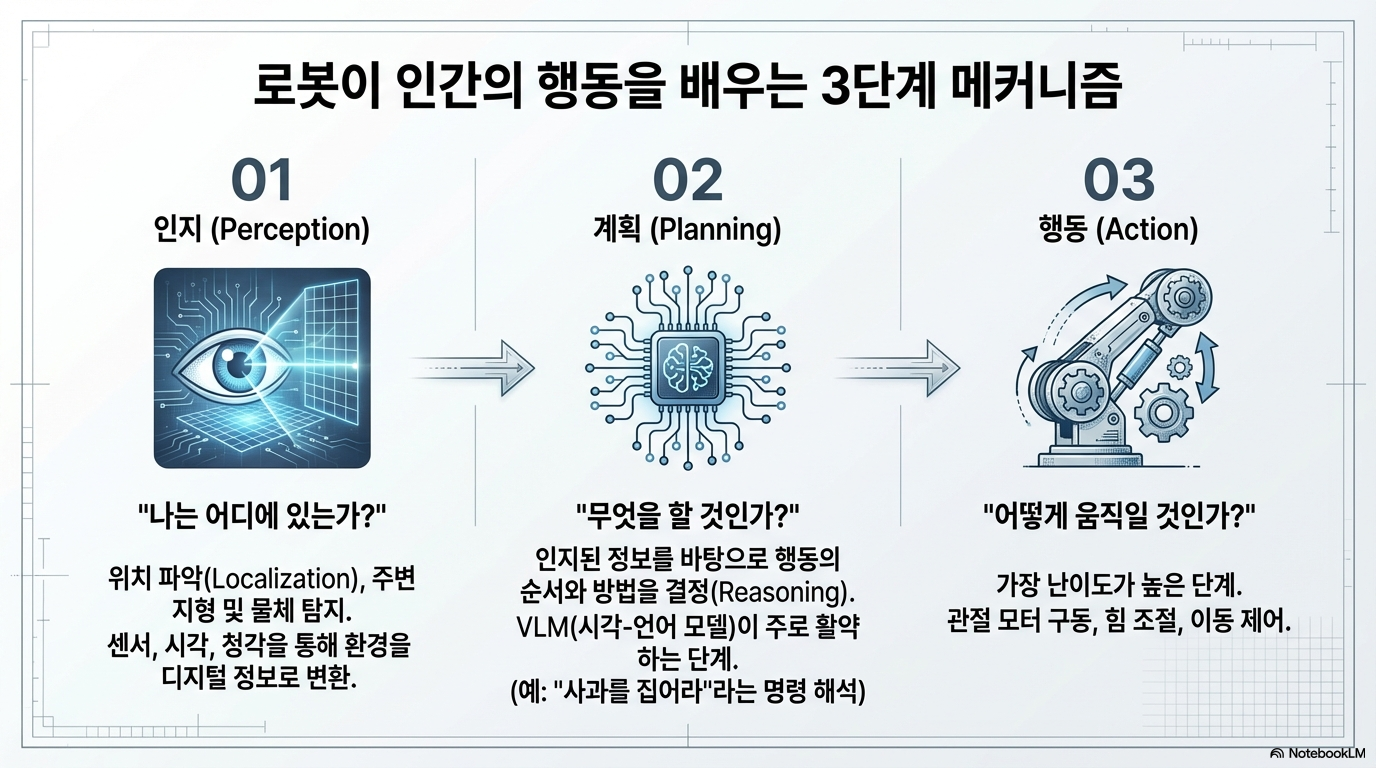

로봇이 인간의 행동을 학습하는 과정은 정교한 메커니즘을 따릅니다. 단순히 명령어를 수행하는 것이 아니라, 주변 환경을 이해하고 논리적인 판단을 거쳐 물리적인 힘으로 변환해야 하기 때문입니다.

• 인지(Perception): 로봇이 자신의 위치를 파악하고 주변 지형과 물체를 탐지하는 단계입니다. 시각뿐 아니라 촉각, 청각 등의 멀티모달 정보를 통해 현재 상황을 데이터화합니다.

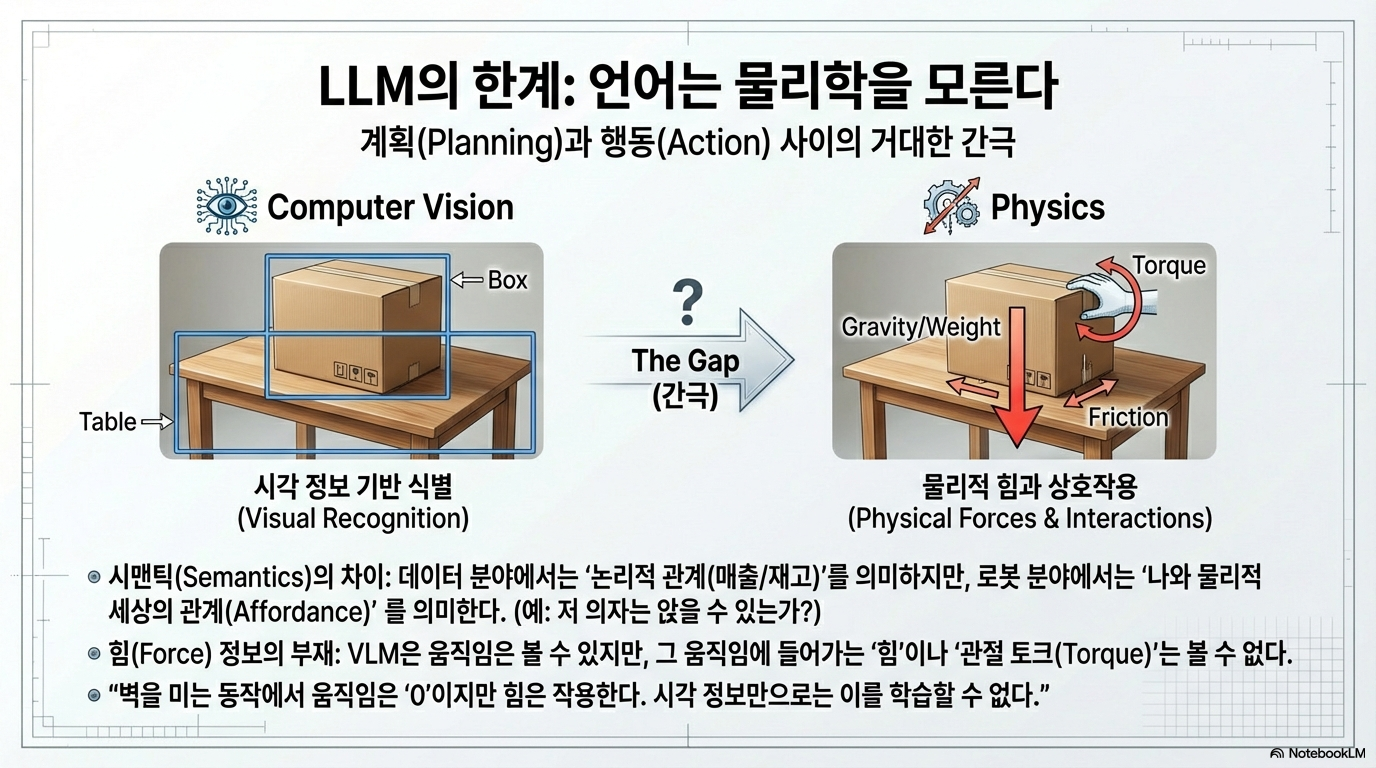

• 계획(Reasoning): 인지된 정보를 바탕으로 행동 지침을 세웁니다. 여기서 핵심은 **VLM(비전 언어 모델)**입니다. 텍스트만 처리하는 LLM은 물체의 정확한 3차원 위치나 장애물 정보를 파악할 수 없기에, '공간적-시각적 인지'가 결합된 VLM이 필수적입니다.

• 행동(Action): 계획된 명령을 실제 근육(모터)의 움직임으로 전환합니다. 로봇 팔의 관절 모터를 어떻게 구동할지 정밀하게 연산하며, **신경망(Neural Network)**이 언어 명령과 실제 물리적 토크(Torque)를 연결하는 가교 역할을 합니다.

분석 및 성찰: 결국 로봇 훈련이란 '목표'와 '움직임' 사이의 간극을 좁히는 과정입니다. 텍스트 명령이 물리적 모터의 회전값으로 변환되기 위해서는 방대한 시각 데이터와 행동 데이터의 동기화가 이루어져야 하며, 이것이 피지컬 AI가 단순 챗봇보다 훨씬 높은 난이도를 갖는 이유입니다.

3. [Takeaway 2] '테슬라 방식'을 닮은 혁신: 센서 하나로 끝내는 로봇 훈련

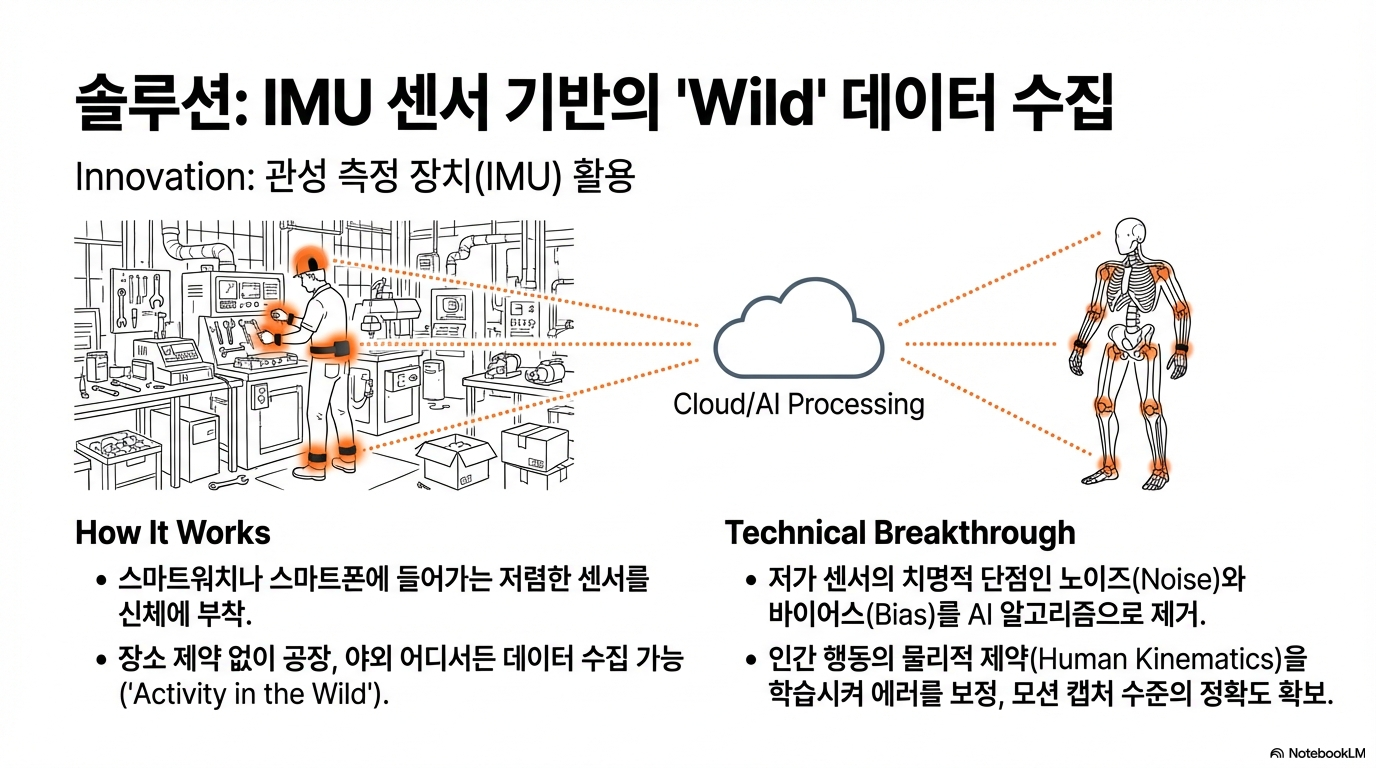

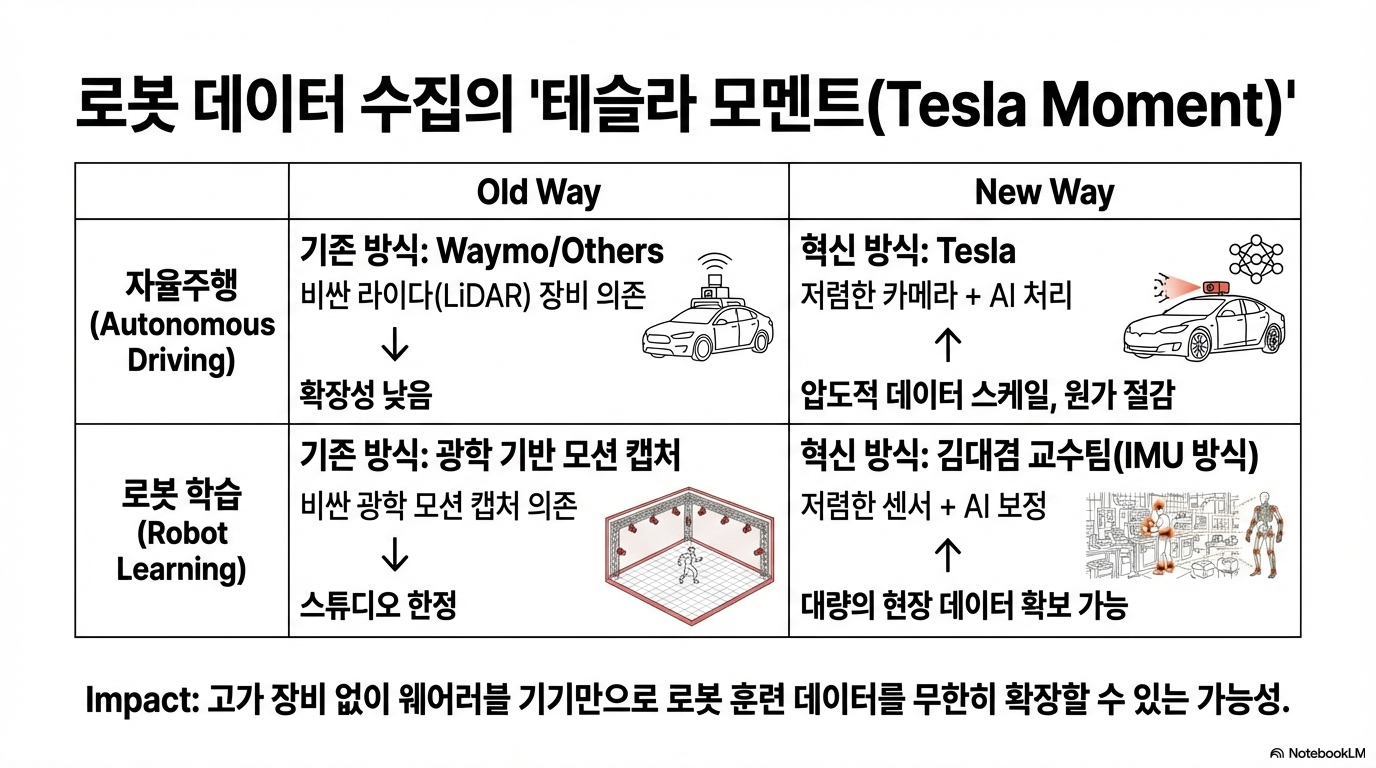

기존 휴머노이드 학습의 주류는 수억 원대 카메라를 동원한 '광학식 모션 캡처'였습니다. mm 단위의 정확도를 자랑하지만, 카메라 시야를 가리는 장애물이 있거나 실험실 밖으로 나가면 무용지물이 된다는 한계가 있었습니다. 김대겸 교수는 이를 IMU(관성 측정 장치) 기반 센서로 돌파했습니다.

그동안 IMU는 가격이 저렴한 대신 '바이어스(Bias)'와 '노이즈(Noise)'라는 치명적인 에러 성분 때문에 주류 기술이 되지 못했습니다. 김 교수는 이를 인공지능으로 해결했습니다. 이른바 '인간 중심 시뮬레이션 활동(Activity in the Human-centric Simulation)' 분석입니다. 예를 들어 "공을 던질 때 손에서 공이 떠나지 않을 수 없다"는 식의 '인간 행동의 물리적 제약 조건'을 AI가 학습하게 하여 센서의 오차를 스스로 교정하게 만든 것입니다.

"저희 같은 경우는 몸에 센서만 붙이면은 측정을 할 수 있기 때문에 자유롭게 움직이면서 데이터를 얻을 수 있는 장점이 있습니다."

분석 및 성찰: 이 방식은 테슬라가 고가의 라이다(LiDAR) 대신 저렴한 카메라 8대만으로 자율주행 데이터를 모은 전략과 궤를 같이합니다. 이는 인프라 의존형 데이터(MoCap/LiDAR)에서 **디바이스 중심 데이터(IMU/Camera)**로의 패러다임 전환을 의미합니다. 스마트폰이나 웨어러블 기기의 IMU 데이터를 활용할 수 있게 됨으로써, 로봇 학습용 '빅데이터'의 대중화가 가능해진 것입니다.

4. [Takeaway 3] 로봇의 지능을 완성하는 '실패의 미학'과 시뮬레이션

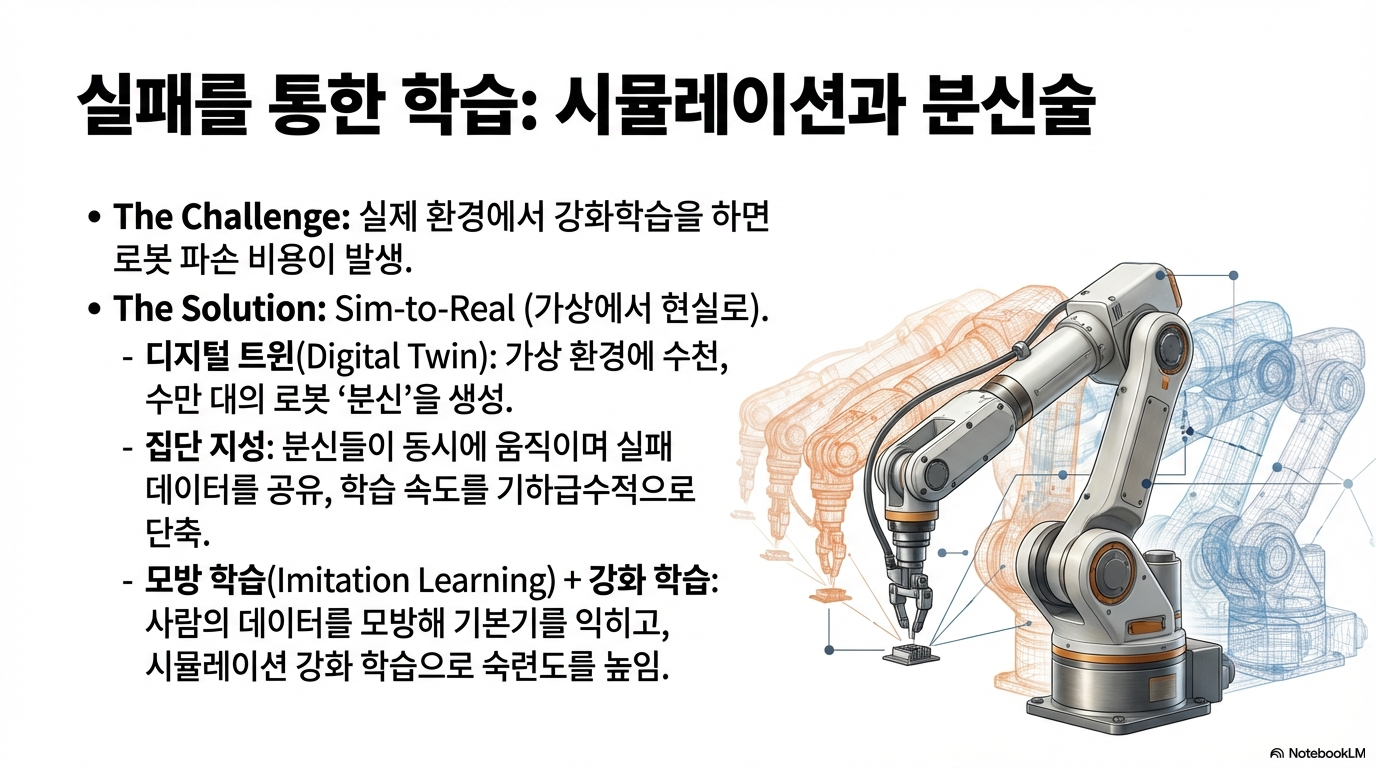

로봇의 지능은 실제 세상에서만 학습되지 않습니다. 오히려 가상 환경에서의 수만 번의 '실패'가 로봇을 완성합니다.

• '분신술(Shadow Clone)' 시뮬레이션: 가상 환경(디지털 트윈)에서 5,000대, 10,000대의 로봇이 동시에 각기 다른 시도를 하며 데이터를 생성합니다. 이들은 서로의 정보를 공유하며 무엇이 '잘못된 움직임'인지 학습합니다.

• 모방 학습과 강화 학습의 조화: 인간의 동작을 그대로 따라 하는 '모방 학습'으로 기초 궤적을 잡고, '강화 학습'의 보상(Reward) 시스템을 통해 예상치 못한 변수에서도 최적의 경로를 찾는 '유연성'을 확보합니다.

분석 및 성찰: 피지컬 AI의 가장 큰 숙제는 가상에서 배운 것을 실제에 적용할 때 발생하는 '심투리얼(Sim-to-Real)' 격차를 극복하는 것입니다. 실패해도 기기가 망가지지 않는 가상 세계에서 강화 학습을 통해 근력을 키우고, 실제 환경의 물리 법칙을 정교하게 반영하는 기술이 로봇의 완성도를 결정짓습니다.

5. [Takeaway 4] 대한민국 로봇 산업의 '치트키': 제조 데이터

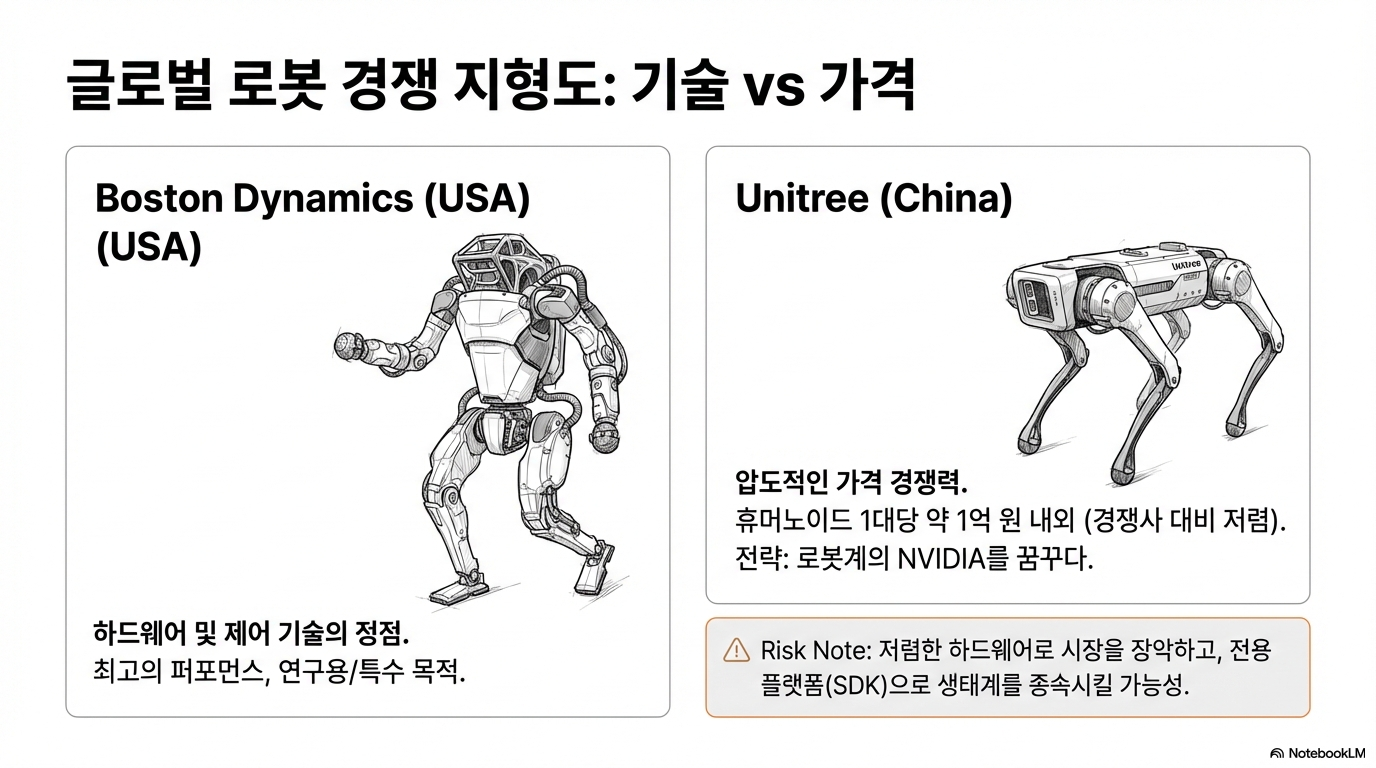

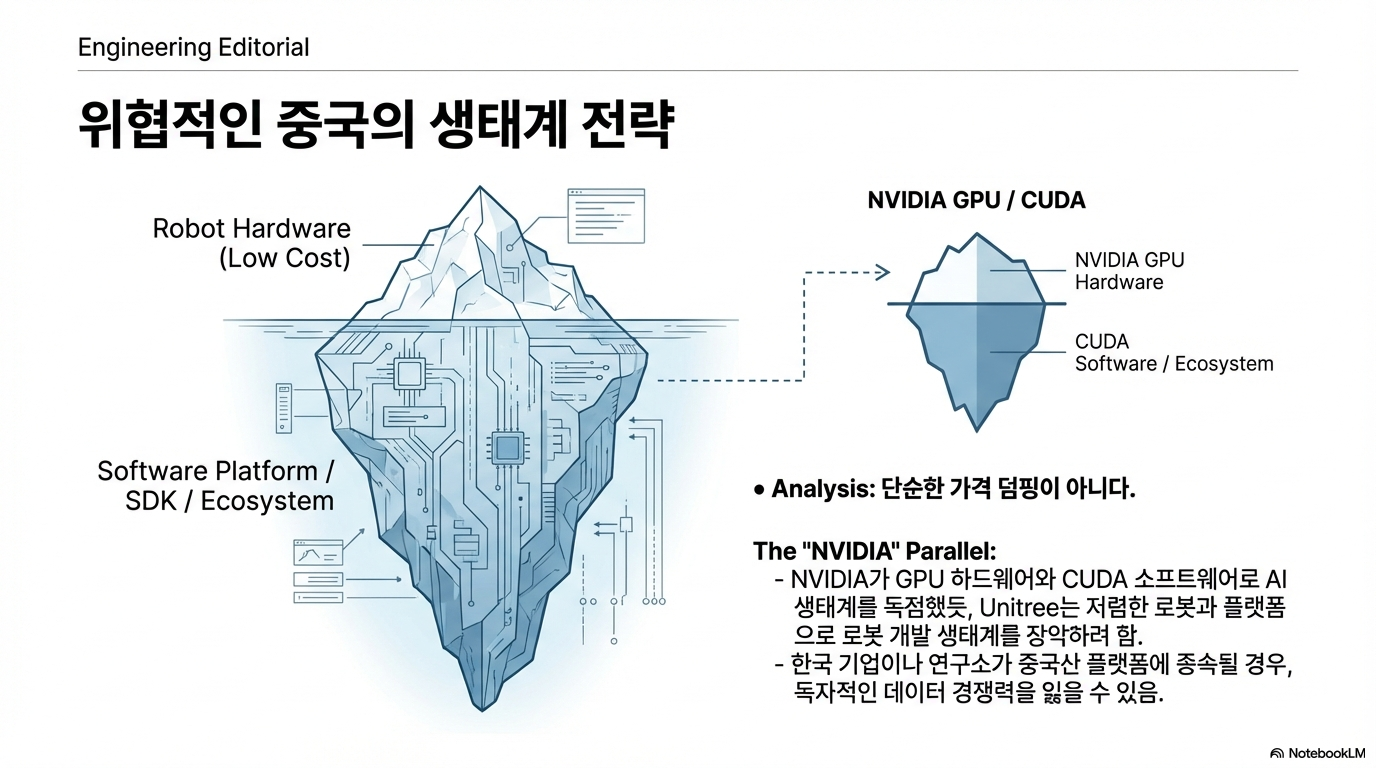

중국의 유니트리(Unitree)가 1억 원 내외의 압도적인 가격 경쟁력과 플랫폼 생태계로 시장을 공략하고 있는 상황에서, 한국의 전략은 달라야 합니다. 김대겸 교수는 그 해답으로 한국이 보유한 **'고난도 제조업 특화 데이터'**를 꼽습니다.

반도체 공정의 정밀한 조작, 조선업 현장의 숙련된 용접 기술 등은 중국이 쉽게 흉내 낼 수 없는 고부가가치 데이터입니다. 한국 엔지니어들의 섬세한 '손기술' 데이터는 피지컬 AI 시대에 가장 강력한 경쟁 우위가 될 것입니다.

분석 및 성찰: 문제는 데이터의 '표준화'입니다. 현재 산업 현장의 데이터는 파편화되어 있고 인공지능이 학습하기 어려운 비정형 상태입니다. 이 산재한 제조 데이터를 AI가 즉시 소화할 수 있도록 정형화하고 표준화된 데이터셋으로 구축하는 것이 로봇 패권 전쟁에서 한국이 승리하기 위한 국가적 과제입니다.

6. 결론: 피지컬 AI, 인간의 상상력을 넘어선 인터랙션의 시대로

피지컬 AI는 단순히 인간을 닮은 '휴머노이드'에 갇히지 않습니다. 김 교수는 휴머노이드가 오히려 "인간 상상력의 한계가 만든 틀"일 수 있다고 지적합니다. 미래의 피지컬 AI는 소프트 로봇, 웨어러블 로봇 등 더 다양한 플랫폼으로 확장될 것입니다.

이를 위해 로봇은 단순히 사물을 보는 것을 넘어 **'시멘틱 레이어(Semantic Layer)'**를 구축해야 합니다. 이는 데이터 간의 논리적 관계를 뜻하는 기존의 시멘틱과 달리, "저 의자는 내가 앉을 수 있는 곳인가?", "저 문은 내가 열 수 있는가?"와 같은 나와 물리 세계 사이의 관계를 정의하는 지능입니다. 여기에 힘의 세기를 느끼는 '키네틱 데이터'와 인간의 감정을 읽는 '심박수(PPG) 센서'가 통합되면 로봇은 비로소 인간의 의도를 이해하는 지능형 동반자가 됩니다.

인간의 상상력이 만든 '휴머노이드'라는 틀을 벗어날 때, 피지컬 AI는 우리 삶의 공간을 어떻게 재정의하게 될까요? 로봇이 오감을 통해 세상을 느끼고 인간의 감정선까지 읽어내는 시대, 우리는 도구가 아닌 새로운 사회적 지능과 공존할 준비를 시작해야 합니다.

728x90

'배움: MBA, English, 운동' 카테고리의 다른 글

| 단순한 속도 그 이상, 6G와 AI가 재편할 연결의 미래: 키사이트가 전하는 4가지 통찰 (4) | 2026.02.13 |

|---|---|

| 15년차 문과 출신 PO가 말하는, AI도 대체 못 할 스펙 초월의 기술 (0) | 2026.02.13 |

| 코스피 6,000 시대와 휴머노이드의 습격: 2026년 투자의 지형도가 바뀐다 (0) | 2026.02.13 |

| 일본 자민당 316석의 경고: '평화헌법'을 뒤흔드는 다카이치 열풍과 일본의 숨겨진 딜레마 (3) | 2026.02.12 |

| "우리는 아무것도 소유하지 못하고, 더 많은 비용을 지불한다": 구독 경제의 배신과 아날로그의 역습 (5) | 2026.02.12 |