TSMC, 폭스콘, 대만 정부와 손잡고 '주권 AI' 시대 준비

엔비디아 CEO 젠슨 황이 대만 타이페이에서 열린 컴퓨텍스(Computex) 행사 직전, 대만에 AI 슈퍼컴퓨터를 구축하겠다는 계획을 발표했습니다. 파트너는 대만의 양대 기술 기업인 TSMC와 폭스콘, 그리고 대만 정부입니다. 글로벌 AI 경쟁이 치열해지는 가운데, "주권 AI(Sovereign AI)"를 위한 인프라를 구축하려는 움직임으로 주목받고 있습니다.

2025년 컴퓨텍스(Computex Taipei)를 앞두고 발표된 엔비디아의 전략은 단순한 제품 출시에 그치지 않았습니다. 젠슨 황 CEO는 TSMC, 폭스콘, 대만 정부와 함께 대만 내 최초의 초대형 AI 슈퍼컴퓨터 구축 계획을 전격 발표하며, AI 산업의 무게중심이 미국 실리콘밸리에서 동아시아, 특히 대만으로 이동하고 있음을 상징적으로 보여주었습니다.

이번 발표는 전 세계적으로 확산되고 있는 '주권 AI(Sovereign AI)' 개념과 맞물려 있습니다. 즉, 각국이 외부 클라우드에 의존하지 않고 자국 내 AI 인프라를 직접 구축하고 통제하겠다는 흐름 속에서, 대만은 자체적인 AI 생태계를 구축함과 동시에, 글로벌 AI 수요를 흡수하는 제조 중심지를 넘어 기술 중심지로 도약하고 있습니다.

AI 슈퍼컴퓨터, 차세대 칩(GPU), NVLink의 개방, 그리고 새로운 CPU 생태계와의 협력 등, 엔비디아의 발표는 제품, 기술, 생태계, 지정학적 전략이 절묘하게 얽힌 종합 패키지였습니다. 이제 대만은 'AI 시대의 심장'이 되려는 꿈을 현실로 만들고 있으며, 엔비디아는 그 중심에서 산업, 정부, 파트너 생태계를 연결하는 구심점 역할을 수행하고 있습니다.

🧠 AI 혁명의 중심, 대만!

"대만은 AI의 심장이다" – 젠슨 황의 선언

황 CEO는 기조연설에서 "대만은 AI 혁명의 중심에 있다"고 강조하며, "이제는 대만이 세계를 위한 슈퍼컴퓨터를 만드는 수준을 넘어, 대만 자체의 AI 인프라를 위한 슈퍼컴퓨터를 구축할 것"이라고 밝혔습니다. 그는 슈퍼컴퓨터의 정확한 스펙은 밝히지 않았지만, 폭스콘은 이후 보도자료를 통해 해당 슈퍼컴퓨터가 엔비디아의 차세대 Blackwell Ultra 시스템과 GB300 NVL 72가 포함될 것이라고 발표했습니다.

젠슨 황 CEO는 이번 컴퓨텍스 키노트에서 대만을 **AI 생태계의 '본진'**이라 표현했습니다. 이는 단순한 수사가 아닙니다. AI 산업의 핵심은 더 이상 소프트웨어나 알고리즘에만 있지 않습니다. GPU, HBM, 네트워크 인터페이스, 패키징 기술 등 첨단 반도체 제조와 고속 데이터 처리 인프라가 동반되지 않으면 AI는 움직일 수 없습니다. 이 모든 기술의 집합지가 바로 대만입니다.

TSMC는 세계 반도체 생산의 60% 이상을 담당하고 있으며, 폭스콘은 글로벌 서버와 데이터센터 장비의 핵심 조립을 담당합니다. 여기에 콴타, 위스트론, SPIL 등 AI 칩 테스트 및 패키징 분야에서 세계적 수준의 기술력을 보유한 기업들이 즐비합니다. 엔비디아는 이를 통해 AI 반도체 설계부터 생산, 테스트, 통합까지 원스톱으로 가능한 유일한 지역으로 대만을 선택한 것입니다.

이런 구조는 미국, 유럽, 중국 어디에서도 흉내 내기 어렵습니다. 대만은 하드웨어적 AI 인프라를 '현장'에서 소화할 수 있는 유일한 거점이며, 이번 슈퍼컴퓨터 건설은 단순한 상징을 넘어 AI 국가 전략의 실질적인 인프라 거점화를 의미합니다.

🧬 반도체 R&D 가속화하는 TSMC

"AI 인프라가 기술 돌파구 만든다" – TSMC CEO

TSMC의 웨이 C.C. 회장은 "이번 AI 슈퍼컴퓨터를 통해 반도체 연구개발 속도를 획기적으로 높일 수 있다"고 강조했습니다. 이는 단순한 AI 인프라 구축을 넘어, 차세대 칩 개발을 위한 기술적 기반으로 활용될 것으로 보입니다. 특히 TSMC는 향후 자사 연구에 이 AI 인프라를 적극 활용할 계획입니다.

TSMC의 CEO인 웨이 C.C.는 이번 프로젝트를 단순한 고객사 지원이 아닌 자사 기술 혁신을 위한 도구로 인식하고 있습니다. TSMC는 이미 2나노미터, 1.6나노미터급 공정 개발에 박차를 가하고 있으며, 최근에는 AI 칩 특화 패키징 기술인 CoWoS-X와 InFO-L를 상용화 단계로 끌어올리고 있습니다. 이 모든 기술은 AI 워크로드가 요구하는 초고속 처리 및 고대역폭 메모리 연결 구조에 최적화되어야 하며, 이런 환경을 실험하고 시험할 수 있는 최적의 테스트베드가 바로 AI 슈퍼컴퓨터입니다.

엔비디아의 GB300 시스템은 차세대 AI 추론 엔진으로, 기존 시스템 대비 1.5배의 성능 향상과 2배의 네트워크 확장성을 제공한다고 합니다. TSMC는 이 플랫폼을 기반으로 차세대 공정이 실제 AI 처리에서 어느 정도 성능을 내는지 실시간 피드백을 받을 수 있게 됩니다. 이는 단순한 공정 미세화 경쟁을 넘어서, ‘AI 중심 설계’ 시대의 기술 검증 플랫폼으로서 결정적인 역할을 하게 됩니다.

또한, TSMC가 주도하고 있는 OIP(Open Innovation Platform) 생태계와 연결되면, 엔비디아와의 슈퍼컴퓨팅 협력은 수천 개의 스타트업과 파운드리 고객들에게도 혜택을 줄 수 있는 기술적 파급력을 갖습니다. 결국 이번 슈퍼컴퓨터는 대만 AI 생태계를 넘어, 글로벌 반도체 혁신 속도를 끌어올릴 엔진이 되는 셈입니다.

🔗 NVLink 개방 선언!

‘자사 생태계’를 넘어, 경쟁자와도 손잡는다

황 CEO는 이번 발표에서 자사의 핵심 기술인 NVLink의 확장도 알렸습니다. 구글, 메타, AWS와 같은 기업이 자체 개발한 칩을 엔비디아의 시스템에 연결할 수 있도록 ‘NVLink Fusion’이라는 새로운 기술을 공개한 것입니다. 또한 Marvell, MediaTek, Astera Labs, Alchips와 같은 기업들도 이 NVLink 생태계에 참여하게 됩니다.

NVLink는 원래 엔비디아가 자사의 GPU 간 고속 데이터 전송을 위해 만든 독자적인 인터커넥트 기술입니다. 기존에는 엔비디아 내부 GPU나 칩셋에만 적용 가능했지만, 이번 발표를 통해 **'NVLink Fusion'**이라는 새로운 기술을 선보이며 게임의 규칙이 바뀌고 있습니다.

NVLink Fusion은 구글, 메타, AWS 같은 클라우드 빅테크들이 직접 설계한 커스텀 칩도 엔비디아의 GPU와 고속으로 연결할 수 있도록 허용합니다. 이는 곧, 과거처럼 '엔비디아 칩만으로 폐쇄 생태계를 구성하겠다'는 전략에서 벗어나, 다양한 칩 생태계를 흡수하며 더 큰 AI 인프라 시장을 장악하겠다는 방향 전환이라 할 수 있습니다.

흥미로운 점은 엔비디아가 NVLink 기술을 MediaTek, Marvell, Astera Labs, Alchip 등 중소·중견 반도체 IP 및 패브리스 기업들에도 개방한다는 점입니다. 이는 엔비디아가 AI 칩 설계 중심에서 벗어나, **AI 인프라 전반의 ‘표준 연결성 플랫폼’**으로 자리잡겠다는 의지로 해석됩니다. 다시 말해, 누구든지 고성능 AI 컴퓨팅을 구축하고 싶다면, 반드시 NVLink로 연결된 생태계에 참여해야 한다는 식입니다.

젠슨 황 CEO의 말처럼, “모든 걸 엔비디아에서 사주면 행복하겠지만, 일부만 사줘도 좋다”는 발언은 단순한 농담이 아닙니다. 그만큼 생태계 확장과 고객 다양화가 엔비디아의 전략적 핵심 축이 되었음을 시사합니다.

🤝 퀄컴도 데이터센터 시장 진입

"고성능 저전력 CPU, AI 시대의 핵심이 될 것"

퀄컴 CEO 크리스티아노 아몬은 이날 기자회견에서 “우리는 고성능·저전력 CPU 아키텍처로 AI 인프라 확장에 중요한 역할을 할 것”이라고 밝혔습니다. 특히 엔비디아 생태계와 협력하며, 추론용 AI 인프라 시장 진입을 준비하고 있다고 설명했습니다.

그동안 퀄컴은 모바일 SoC 시장에서의 지배력에 비해 데이터센터 분야에서는 존재감이 미미했습니다. 하지만 이번 컴퓨텍스에서 크리스티아노 아몬 CEO는 명확한 방향 전환을 예고했습니다. 그는 퀄컴이 이제 고성능·저전력 CPU를 앞세워 AI 데이터센터 시장에 본격 진입하겠다고 선언했습니다.

퀄컴은 이미 Arm 기반의 커스텀 CPU 아키텍처를 독자적으로 설계해왔으며, 이는 엔비디아의 GPU 또는 AI 가속기와 결합할 수 있는 이상적인 구조입니다. AI 추론(inference)이나 로우파워 컴퓨팅이 요구되는 환경에서 퀄컴의 기술은 특히 강점을 가질 수 있습니다. 아몬 CEO는 “모든 AI 가속기에는 반드시 CPU가 필요하다”며, 퀄컴의 CPU가 AI 인프라의 기본 뼈대 역할을 할 수 있다고 강조했습니다.

또한 퀄컴은 엔비디아 생태계에 공식적인 CPU 공급사로 합류함으로써, NVLink를 포함한 차세대 AI 시스템의 주요 파트너로 떠오르고 있습니다. 제품 로드맵은 아직 공개되지 않았지만, 향후 공개될 데이터센터 전용 CPU 제품은 AMD나 인텔과 정면으로 경쟁하게 될 것으로 예상됩니다.

결국 퀄컴의 이번 선언은 AI 칩 생태계가 GPU 중심에서 CPU-GPU 상호보완 구조로 확장되고 있음을 의미합니다. 이는 AI 인프라 시장에서의 새로운 동력 확보 경쟁이 본격화되고 있음을 알리는 신호탄이라 할 수 있습니다.

🚀 GB300, 3분기 출격 준비 완료

기존 슈퍼컴퓨터 성능을 능가하는 AI 시스템

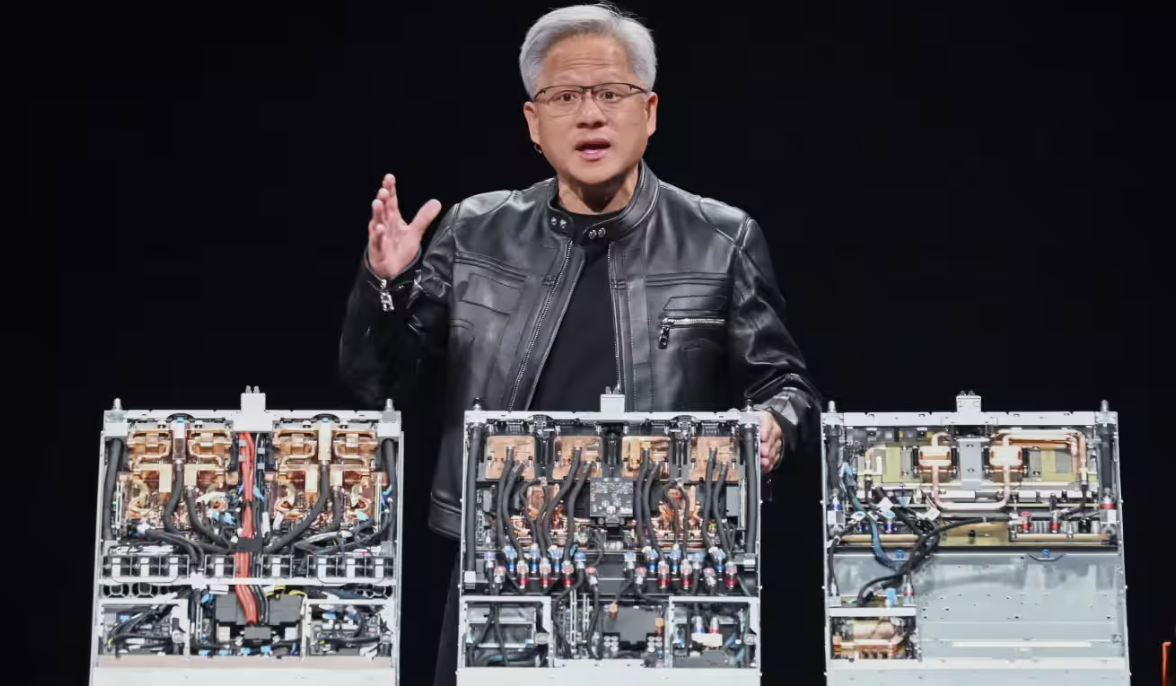

엔비디아는 차세대 GB300 시스템이 올해 3분기에 출시된다고 밝혔습니다. 이 시스템은 이전 대비 1.5배 향상된 추론 성능, 1.5배 높은 HBM 대역폭, 그리고 2배의 네트워크 용량을 자랑합니다. 젠슨 황은 "GB300은 과거 미국의 슈퍼컴퓨터 '시에라(Sierra)'와 맞먹는 수준의 성능"이라고 자신 있게 말했습니다.

젠슨 황 CEO는 기조연설에서 “GB200은 이미 풀 프로덕션 단계에 돌입했으며, 후속 모델 GB300은 2025년 3분기에 정식 출시될 것”이라고 밝혔습니다. GB300은 단순한 차세대 AI 칩이 아닙니다. 엔비디아의 최신 Blackwell 아키텍처를 기반으로 설계된 이 칩은 AI 추론 성능에서 1.5배 향상, HBM 대역폭도 1.5배 확대, 네트워크 연결성은 2배 강화된 초고성능 컴퓨팅 솔루션입니다.

이 GB300이 탑재될 GB300 NVL 72 시스템은 실질적으로 하나의 데이터센터를 대체할 수 있을 정도의 처리 능력을 갖추게 되며, 이는 2018년에 출시된 미국의 대표적 슈퍼컴퓨터인 '시에라(Sierra)'와 동등한 성능 수준입니다. 이는 단지 클러스터의 연산량을 높인 것이 아니라, AI 추론(특히 LLM 기반 모델의 실시간 서비스화)에 최적화된 구조로 개선되었다는 점에서 차별화됩니다.

또한, 이 시스템은 AI 기업뿐만 아니라 국가 단위의 주권 AI 전략, 즉 자체적인 AI 인프라 구축을 목표로 하는 정부 및 대기업들에게도 이상적인 솔루션으로 각광받고 있습니다. 이미 사우디아라비아의 AI 기업 Humain에 18,000개의 GPU를 공급하기로 발표한 것도 같은 맥락이며, GB300은 그 상징적인 'AI 국가 인프라 수출 패키지'의 핵심 칩이 될 가능성이 큽니다.

🏢 ‘엔비디아 컨스텔레이션’ 본사도 타이베이에 설립

대만 공급망과의 초밀착 전략

젠슨 황은 엔비디아가 타이베이에 대규모 사무소인 **‘Nvidia Constellation’**을 설립한다고 밝혔습니다. 이는 대만 내 수많은 공급업체와의 협업을 강화하고, AI 인프라 생태계 구축에 박차를 가하기 위함입니다. 황은 이번 방문 중 TSMC, SPIL, 폭스콘, 콴타, 위스트론 등과 만찬을 함께하며 협업을 논의했습니다.

젠슨 황은 이번 발표에서 새로운 오피스 캠퍼스인 **‘Nvidia Constellation(엔비디아 컨스텔레이션)’**을 타이베이에 설립하겠다고 밝혔습니다. 단순한 현지 법인이 아닌, R&D, 공급망 조율, 고객 대응, 기술 협력을 모두 아우르는 복합 기능 본사로 설계된 것이 특징입니다.

이러한 전략은 명백한 현실 인식에서 비롯되었습니다. 대만은 TSMC, SPIL, Foxconn, Quanta, Wistron 등 글로벌 반도체 및 AI 시스템 공급망의 핵심 거점입니다. 젠슨 황은 실제로 이번 방문 중 이러한 핵심 공급업체의 고위 경영진과 오찬 및 만찬을 가지며, 현지 파트너와의 공급 연계 및 협업 체계 강화에 집중했습니다.

‘Constellation’이라는 이름도 상징적입니다. 여러 별들이 모여 하나의 별자리를 이루듯, 다양한 기술 파트너들과의 협업을 통해 AI 우주를 만들겠다는 비전이 담겨 있습니다. 이곳은 단순한 현지 운영센터가 아닌, AI 인프라 산업을 주도할 거점 중 하나로 발전할 것입니다.

이와 함께, 타이베이 오피스는 향후 엔비디아가 동아시아 지역에서 AI 칩 수출, 협력사 교육, 소프트웨어 생태계 확산 등 전방위적인 거점으로 기능할 예정입니다. 이는 엔비디아가 AI 공급망의 ‘심장’을 미국에서 아시아, 그 중에서도 대만으로 분산시키고자 하는 전략적 행보로 해석할 수 있습니다.

🧭 결론: AI 인프라 패권 경쟁, 대만에서 다시 시작된다

‘주권 AI’는 국가전략, 엔비디아는 그 중심에

엔비디아의 이번 발표는 단순한 제품 공개를 넘어서, AI 시대의 국가 전략인 '주권 AI'에 대한 본격적인 행보라 할 수 있습니다. 대만은 엔비디아, TSMC, 폭스콘이라는 글로벌 기술 3대 축과 함께 AI 슈퍼컴퓨터 생태계를 구축하며 글로벌 AI 주도권 경쟁에서 한 발 앞서 나가게 되었습니다.

이제 AI는 국가가 직접 설계하고 통제하는 전략 자산이 되었고, 그 중심에 엔비디아가 있다는 사실을 다시금 각인시키는 계기가 되었습니다.

이번 엔비디아 발표는 단순히 새로운 제품 하나를 소개한 것이 아닙니다. 그것은 AI 시대의 글로벌 패권을 둘러싼 새로운 전선의 시작을 알리는 '타이베이 선언'이었습니다.

이제 AI 시장은 단순히 누가 더 빠르고 강한 GPU를 설계하느냐를 넘어, 누가 더 강력한 AI 인프라 생태계(칩 + 연결성 + 시스템 + 소프트웨어)를 갖추느냐의 싸움으로 확장되고 있습니다. GB300과 Blackwell Ultra는 그 핵심 기술이며, NVLink Fusion은 이 생태계를 여타 칩 개발사와 연결하는 전략적 고리입니다. 여기에 퀄컴, 미디어텍, AWS, 구글 등도 합류하며, 엔비디아 중심의 AI 하드웨어 연합군이 형성되고 있습니다.

또한 타이베이에 설립될 ‘엔비디아 컨스텔레이션’ 캠퍼스는 이러한 생태계 확장의 물리적 거점이자, 엔비디아가 글로벌 AI 공급망의 심장부에 얼마나 깊숙이 뿌리내리려는지를 보여주는 상징적 조치입니다.

궁극적으로 이번 발표는 하나의 메시지를 던집니다:

"AI 인프라 시대의 진짜 경쟁은 이제 막 시작되었고, 그 중심에 엔비디아와 대만이 있다."

'배움: MBA, English, 운동' 카테고리의 다른 글

| ✈️ 미래를 나는 슈퍼컴퓨터: 차세대 전투기의 진화 (68) | 2025.05.20 |

|---|---|

| 🚀 아마존, 세계 최대 스타트업을 지향하다 (26) | 2025.05.20 |

| 🍎 애플의 현재와 미래: AI 전환점에서 다시 빛날까? (32) | 2025.05.19 |

| 🚀 AMD, 2년 내 주가 111% 상승할 수 있을까? (23) | 2025.05.19 |

| 🇺🇸 2025년 미국 반도체 산업 타임라인 📅 (51) | 2025.05.18 |