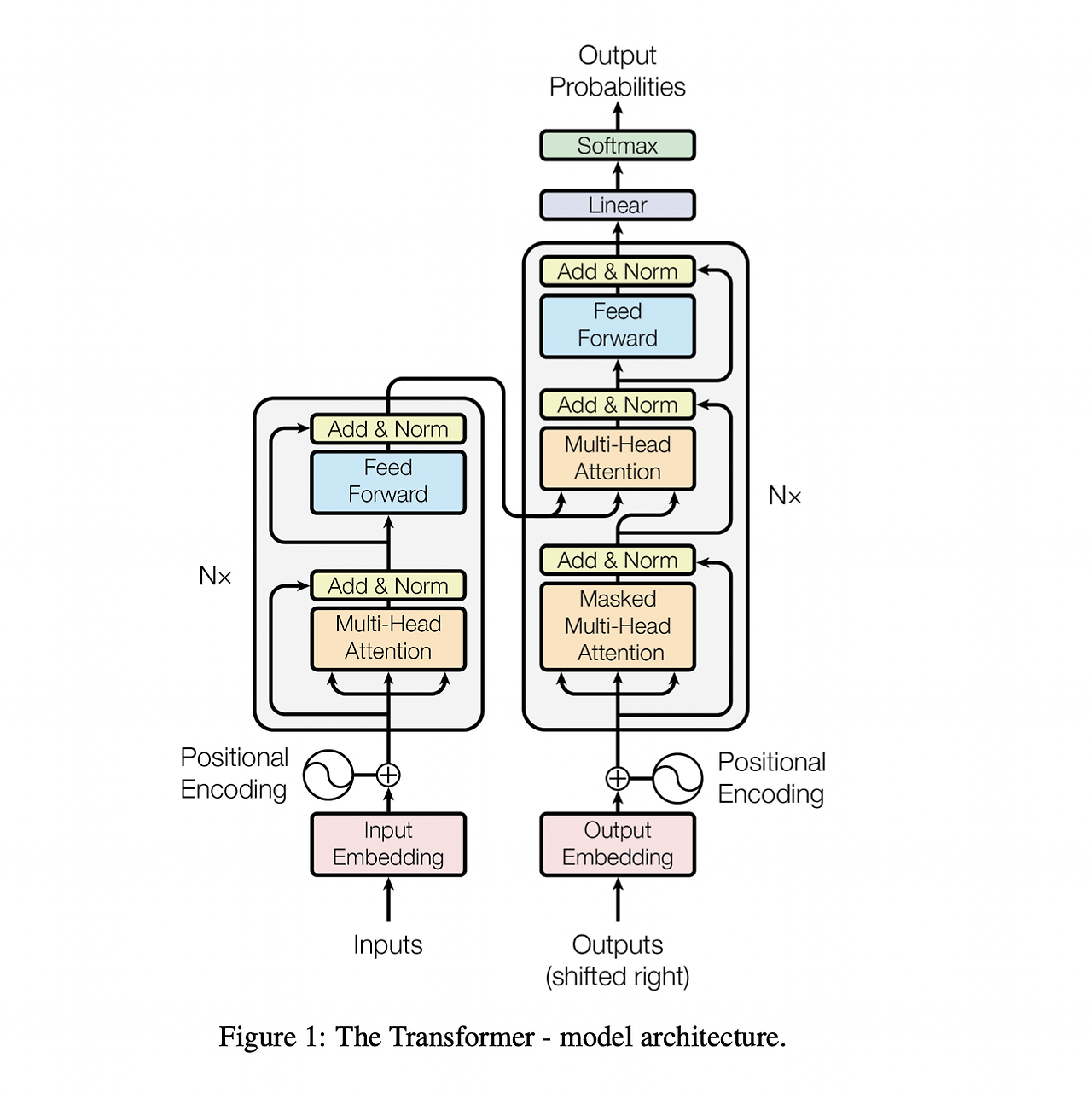

Transformer 모델은 2017년 구글의 논문 *"Attention is All You Need"*에서 처음 소개된 이후, AI 기술에 큰 변혁을 일으켰습니다. 이 모델은 순차적 데이터 처리가 필수적이었던 기존의 RNN이나 LSTM과 달리, Self-Attention과 Multi-Head Attention 메커니즘을 통해 병렬 처리가 가능한 혁신적인 아키텍처를 제안했습니다. 이로 인해 Transformer는 속도와 성능 면에서 뛰어난 결과를 제공하며, 단순한 NLP 작업을 넘어 다양한 분야로 활용 가능성을 확장하게 되었습니다. 오늘날에는 BERT, GPT, ViT와 같은 모델이 등장하여 AI 모델의 표준 아키텍처로 자리 잡았고, 특히 대규모 데이터를 학습할 수 있는 능력 덕분에 초거대 언어 모델과 같은 혁신적인 AI 솔루션이 가능해졌습니다.

이 글에서는 Transformer 모델의 구조와 주요 기술을 살펴보고, 이 모델이 어떻게 확장 가능성을 갖추게 되었는지, 그리고 다양한 산업과 AI 응용 분야에서 어떤 가능성을 열고 있는지 구체적으로 탐구해보겠습니다. 이를 통해 Transformer가 AI 혁신을 가속화하는 데 어떤 기여를 했는지, 그리고 미래의 AI 발전에 있어 Transformer의 중요성이 무엇인지 이해하게 될 것입니다.

1. Attention Mechanism의 도입

기존의 RNN (Recurrent Neural Networks)이나 LSTM (Long Short-Term Memory) 모델은 순차적으로 정보를 처리하기 때문에 시퀀스가 길어질수록 효율성이 떨어지며, 문장의 앞뒤에 위치한 단어들 간의 관계를 멀리서 참조하기가 어려웠습니다. 이는 문장 이해에 있어 중요한 요소를 간과하거나, 문맥을 파악하는 데 한계가 생기게 했습니다.

Attention Mechanism은 이러한 한계를 해결하기 위해 고안된 것으로, 입력 시퀀스 내의 모든 단어들이 서로와의 관계를 고려할 수 있게 만듭니다. 예를 들어, 문장 번역의 경우 “The book is on the table”이라는 문장에서, ‘book’과 ‘table’이 관계를 이루어 문장의 의미가 결정됩니다. Attention Mechanism을 통해 ‘book’이라는 단어가 문장의 어느 부분과 연관이 있는지를 모델이 스스로 학습하며, 이는 모델이 보다 정확한 문맥 이해와 번역을 가능하게 합니다.

Attention 메커니즘은 이러한 단어들 간의 연관성을 가중치로 표현합니다. 예를 들어 ‘book’이라는 단어가 번역할 때 중요한 단어라면, 그에 해당하는 가중치가 높게 설정되고 덜 중요한 단어에는 낮은 가중치가 부여됩니다. 이처럼 단어마다 가중치를 달리하여 학습함으로써, 모델은 문맥에서 중요한 정보를 강조하고 덜 중요한 정보는 배제하게 됩니다. 이러한 과정을 통해 모델은 단어들 간의 의존 관계를 스스로 파악하고, 더욱 정확한 문장 이해와 생성이 가능해집니다.

결국 Attention Mechanism은 모델이 입력 전체를 한 번에 참조하면서도 중요도가 높은 부분에 집중할 수 있게 함으로써, AI의 정확성과 성능을 극대화했습니다.

2. Self-Attention을 통한 병렬처리 및 학습 효율성 향상

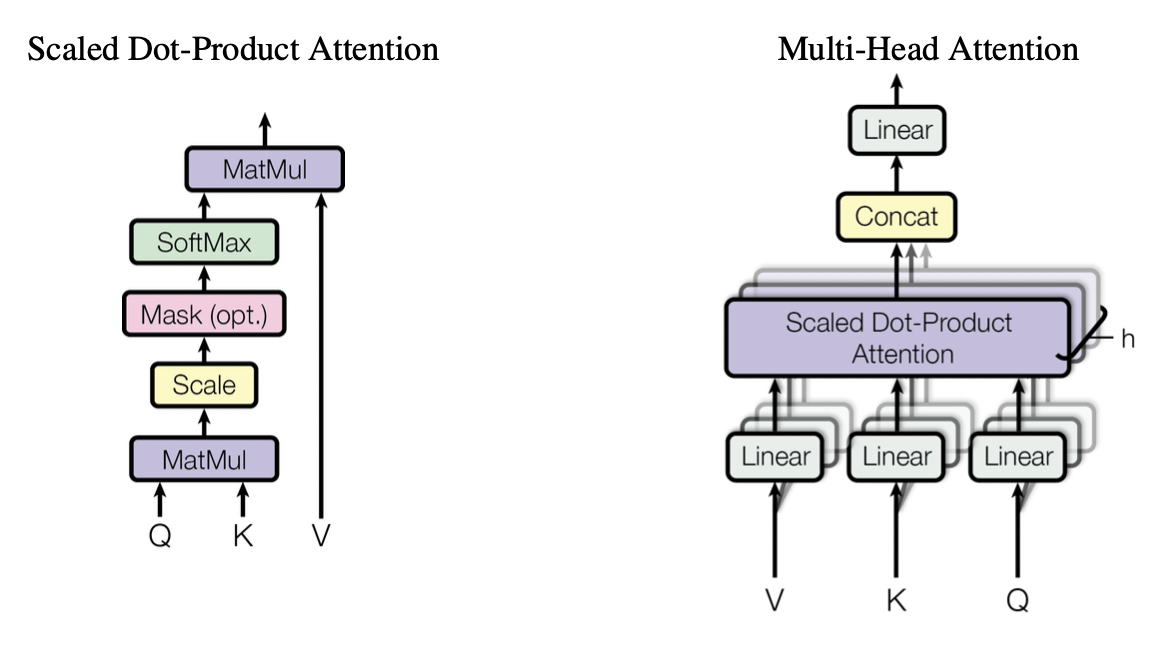

Self-Attention은 Attention Mechanism의 한 형태로, 각 단어가 문장 내 다른 모든 단어와 어떻게 관련되는지를 학습할 수 있도록 설계된 메커니즘입니다. 이는 Transformer 모델의 핵심 구성 요소로, 단어가 다른 단어들과의 관계를 스스로 계산하여 문맥을 이해할 수 있게 합니다. 이러한 Self-Attention 메커니즘은 입력 데이터의 특정 위치에 있는 단어가 다른 위치의 단어들과 어떻게 관련되어 있는지를 연산하여, 문장의 구조와 문맥을 파악합니다.

Self-Attention의 가장 큰 장점 중 하나는 병렬처리가 가능하다는 점입니다. RNN이나 LSTM은 순차적으로 데이터를 처리하기 때문에 단어를 하나씩 순서대로 학습하지만, Self-Attention은 문장 내 모든 단어의 관계를 동시에 계산할 수 있어 병렬 연산이 가능해집니다. 이를 통해 모델 학습 속도가 획기적으로 향상되었고, 대용량 데이터에 대한 학습에서도 높은 효율성을 보장하게 되었습니다.

Self-Attention의 구체적인 과정은 다음과 같습니다:

- Query, Key, Value 벡터 생성: 각 단어는 Query, Key, Value 세 가지 벡터로 변환됩니다. Query는 특정 단어가 다른 단어와의 관계를 어떻게 찾을지 결정하고, Key는 다른 단어와의 관계성을 측정하는 기준이 되며, Value는 최종적으로 어떤 정보를 유지할지 결정합니다.

- 단어 간의 유사도 계산: Query와 Key 벡터 간의 내적 연산을 통해 각 단어가 다른 단어와 얼마나 유사한지를 계산합니다. 이를 통해 단어 간의 상관관계가 높은지 낮은지를 판단할 수 있습니다.

- 가중치 적용 및 정보 집계: 각 단어의 관계 정도를 나타내는 유사도에 따라 Value 벡터에 가중치를 부여하고, 이를 합산하여 최종적으로 문장의 의미를 추출합니다. 가중치가 높을수록 해당 단어는 중요한 정보를 제공하게 되고, 낮은 가중치는 덜 중요한 정보를 나타내게 됩니다.

이와 같은 Self-Attention 프로세스는 병렬 처리를 가능하게 할 뿐만 아니라, 모델이 더 깊은 문맥적 이해를 할 수 있도록 도와줍니다. 결과적으로, 문장 내의 모든 단어가 상호 작용하면서 전체 문맥을 파악하게 되어, NLP 모델이 문장의 의미를 더 잘 이해할 수 있게 되었고, 이를 기반으로 다양한 AI 애플리케이션에서 뛰어난 성능을 발휘할 수 있게 되었습니다.

3. AI의 발전을 가속화한 Multi-Head Attention

Multi-Head Attention은 Transformer 모델의 성능을 극대화하는 핵심 기술로, Attention 메커니즘을 여러 개의 '헤드'로 나누어 다양한 관점에서 문맥을 이해할 수 있게 하는 방식입니다. 기존의 단일 Attention 메커니즘은 단어 간의 관계를 한 차원에서 분석할 수밖에 없지만, Multi-Head Attention은 다수의 Attention을 병렬로 운영하여 여러 관점에서 문장의 다양한 의미와 문맥을 동시에 파악할 수 있습니다. 이를 통해 AI는 문장 구조의 복잡한 의미를 더 세밀하고 깊이 있게 이해할 수 있습니다.

Multi-Head Attention의 구체적인 과정은 다음과 같습니다:

- 다중 Attention 헤드 생성: 입력 데이터를 여러 개의 Attention 헤드로 나누어, 각 헤드가 서로 다른 Query, Key, Value 벡터를 생성합니다. 각 헤드는 고유한 가중치와 파라미터를 갖기 때문에, 서로 다른 방식으로 문장의 특정 패턴을 학습하게 됩니다. 예를 들어, 하나의 헤드는 문법적인 관계를 집중적으로 학습할 수 있고, 다른 헤드는 단어 간의 의미적 유사성을 학습할 수 있습니다.

- 병렬 연산으로 다양한 관점 학습: 각 헤드는 서로 다른 방식으로 단어 간의 관계를 파악하고, 다양한 시각에서 문맥을 이해하게 됩니다. 예를 들어, "The cat sat on the mat"라는 문장에서 하나의 헤드는 "cat"과 "mat" 사이의 위치 관계에 집중할 수 있고, 다른 헤드는 "cat"과 "sat"의 동작과 대상 간의 관계에 초점을 맞출 수 있습니다. 이로 인해 모델은 단순히 단어의 순서가 아닌, 각 단어가 문장에서 차지하는 여러 의미적 역할을 동시에 학습하게 됩니다.

- 결합을 통한 종합적 문맥 이해: 다중 헤드의 출력 결과는 최종적으로 결합되며, 이를 통해 모델은 문장의 다양한 의미와 복잡한 관계를 한 번에 종합적으로 이해할 수 있습니다. 이러한 과정은 단순한 문장 구조를 넘어, 문장의 숨겨진 의미와 복합적인 문법적, 의미적 패턴을 포착할 수 있게 만들어줍니다.

이렇게 Multi-Head Attention은 모델이 한 번의 연산으로 여러 관점에서 문장을 파악할 수 있게 하여, 정확한 문맥 이해와 언어의 미세한 뉘앙스까지 고려할 수 있게 했습니다. 이를 통해 기존 모델보다 훨씬 더 정교하고 효율적인 텍스트 생성과 번역, 질문 응답 시스템 등이 가능해졌으며, 이는 AI의 발전을 가속화하는 주요 요인이 되었습니다.

4. 혁신적 구조로 인한 범용성 증가

Transformer 모델의 구조적 혁신은 NLP 외의 다양한 AI 애플리케이션에도 적용할 수 있는 범용성을 제공했습니다. 이 모델은 자연어 처리뿐만 아니라 이미지 인식, 음성 처리, 그리고 시계열 예측 등에서도 탁월한 성능을 보이며, AI 모델의 새로운 표준으로 자리 잡았습니다.

Transformer 모델의 범용성을 높인 주요 이유는 다음과 같습니다:

- 입력 형태의 유연성: Transformer는 시퀀스의 순차적 처리에 의존하지 않고 Self-Attention 메커니즘을 통해 입력 데이터의 모든 위치를 동시에 참조할 수 있습니다. 이는 입력 데이터가 텍스트, 이미지, 음성, 또는 다른 형식이라도 동일한 메커니즘을 통해 학습할 수 있음을 의미합니다. 예를 들어, 이미지 처리를 위해 입력 이미지를 시퀀스 형태로 분할하고 Self-Attention을 적용하여 픽셀 간의 관계를 학습할 수 있습니다. 이는 비전 트랜스포머(ViT) 모델과 같은 다양한 형태의 트랜스포머 모델을 가능하게 했습니다.

- 모듈형 구조로 인한 확장성: Transformer는 인코더와 디코더 구조로 이루어져 있으며, 각 모듈은 독립적으로 구성되어 있어 여러 방식으로 커스터마이징이 가능합니다. 예를 들어, BERT는 Transformer의 인코더만을 사용하여 자연어 처리에 최적화된 모델로 개발되었고, GPT는 디코더만을 활용해 텍스트 생성에 강점을 지닌 모델로 발전했습니다. 이러한 구조적 유연성 덕분에 Transformer는 목적에 맞게 다양하게 변형될 수 있으며, NLP를 넘어 다양한 AI 분야로의 확장이 가능해졌습니다.

- 대규모 학습 데이터에서의 확장 가능성: Transformer 모델은 다량의 데이터를 학습할 때 성능이 더욱 높아지는 특징을 지니고 있습니다. 기존의 모델들은 학습 데이터가 증가함에 따라 점차적으로 성능의 한계를 드러내는 반면, Transformer는 대규모 데이터에서 성능이 더욱 강화되어 대형 언어 모델(GPT-3, T5 등)에서 활용되며 발전해왔습니다. 이로 인해, AI가 더욱 방대한 데이터에서 인간처럼 언어를 이해하고 생성하는 능력을 갖추게 되었고, 이는 산업 전반에 걸쳐 AI 활용 범위를 확장하는 계기가 되었습니다.

이러한 범용성은 Transformer가 다양한 데이터 유형과 문제에 적응하여 폭넓은 활용 가능성을 가지게 만들었으며, AI 모델들이 특정 문제에 국한되지 않고 폭넓은 문제 해결에 기여할 수 있는 기반이 되었습니다. Transformer 모델은 이제 단순한 NLP 모델을 넘어 여러 산업에 걸쳐 AI 혁신을 이끄는 기반 기술로 자리잡았습니다.

5. AI 모델의 확장 가능성

Transformer 모델은 기존의 AI 모델들보다 훨씬 더 큰 데이터 세트에서 학습이 가능하며, 모델 자체도 확장성이 뛰어납니다. 예를 들어, BERT, GPT와 같은 대형 모델들은 Transformer의 구조를 바탕으로 점차 발전해왔으며, 이는 AI가 점점 더 인간의 언어를 깊이 있게 이해하고 생성할 수 있게 했습니다.

이 논문이 AI 혁명에 기여한 점은 다음과 같이 요약할 수 있습니다:

- 효율성 향상: 병렬 처리로 학습 속도와 효율성 증가

- 범용성: 다양한 응용 가능성으로 NLP, 컴퓨터 비전 등 여러 분야에서 혁신 가능

- 언어 이해 심화: Self-Attention, Multi-Head Attention 등으로 문맥 및 의미 파악 능력 개선

- 확장 가능성: 모델 크기와 학습 데이터 양의 증가에도 성능 향상을 가능하게 함

이 논문은 이후의 AI 및 NLP 모델, 특히 대형 언어 모델의 발전을 견인했으며, 오늘날의 AI 기술을 가능하게 한 기틀을 마련했습니다. Transformer는 이제 AI 모델의 표준 아키텍처 중 하나로 자리잡아 계속해서 혁신을 이끌고 있습니다.

결론

Transformer 모델의 등장은 AI 발전의 속도를 크게 앞당기며, 오늘날 AI 모델들이 직면했던 확장성과 응용의 한계를 넘어설 수 있는 기틀을 마련했습니다. 병렬 학습이 가능하고 다양한 데이터 형태를 처리할 수 있는 범용성을 갖춘 Transformer는 자연어 처리, 이미지 인식, 금융 데이터 분석, 의료 데이터 해석 등 다양한 산업과 도메인에서 실질적인 문제 해결을 가능하게 하고 있습니다. 특히 BERT와 GPT-3와 같은 초거대 언어 모델은 인간의 언어 이해와 생성 능력을 크게 향상시키며, AI의 활용 가능성을 폭넓게 확장했습니다.

앞으로 Transformer 모델의 구조는 더 많은 연구와 발전을 통해 새로운 도전 과제와 기회를 맞이할 것입니다. 예를 들어, 보다 가볍고 효율적인 모델을 개발하는 방향이나 특정 도메인에 최적화된 변형 모델들이 등장하면서 AI 솔루션의 범위와 능력이 더욱 넓어질 것입니다. Transformer는 단순한 기술을 넘어, AI 혁신의 새로운 표준으로 자리 잡고 있으며, 미래의 AI 기술이 인간의 언어와 사고를 더욱 깊이 이해하고, 사회적 가치 창출에 기여할 수 있도록 지속적인 발전을 이끌어갈 것입니다.

https://arxiv.org/abs/1706.03762

Attention Is All You Need

The dominant sequence transduction models are based on complex recurrent or convolutional neural networks in an encoder-decoder configuration. The best performing models also connect the encoder and decoder through an attention mechanism. We propose a new

arxiv.org

'배움: MBA, English, 운동' 카테고리의 다른 글

| 테슬라와 BYD, 전통적인 자동차 제조업체를 제치고 이익 성장 (16) | 2024.11.15 |

|---|---|

| 아시아, '상식적' 외교정책을 내세우는 트럼프 팀의 귀환에 불안감 (15) | 2024.11.15 |

| DeepMind, AlphaFold 3 코드 공개: 생물학 연구의 혁신을 가속화하다 (12) | 2024.11.14 |

| 일본 스카이 퍼펙트 JSAT: 아시아 최고의 우주 기업을 목표로 (10) | 2024.11.14 |

| 미래 항공 모빌리티: 새로운 교통 수단의 등장 (16) | 2024.11.14 |