온디바이스 AI 도입 경쟁이 뜨겁다

스마트폰은 지난 10년간 통신, 정보 소비, 엔터테인먼트의 중심 기기로 진화해왔습니다. 하지만 2024년을 기점으로 우리는 스마트폰의 또 다른 패러다임 전환을 목격하고 있습니다. 그것은 바로, 스마트폰이 AI 생성의 중심 허브로 자리 잡고 있다는 점입니다.

이제 사용자들은 단순히 AI 서비스를 ‘받는’ 것이 아니라, 자신의 손 안에서 직접 생성형 AI 기능을 실행하고 경험하기를 원합니다. 실시간 텍스트 요약, 음성 명령 해석, 콘텐츠 자동 생성, 오프라인 번역과 같은 기능이 모두 스마트폰 내부에서 처리되길 기대하는 시대가 된 것입니다.

이러한 요구는 데이터센터 중심의 클라우드 AI 구조가 갖는 근본적인 한계—지연 시간, 개인정보 우려, 비용 문제—를 빠르게 드러냈고, 이에 대한 해법으로 **온디바이스 AI(On-device AI)**가 급부상하게 되었습니다. 이는 단순한 기능 탑재를 넘어서, 스마트폰의 아키텍처, 반도체 설계, 운영체제 구조, 심지어 기업의 철학과 서비스 전략까지도 바꾸는 거대한 전환점입니다.

결과적으로 SoC(System on Chip) 기업들은 AI 연산을 어떻게 기기 내에 통합할 것인가에 대한 기술적 전략을 넘어, 어떤 사용자 경험과 데이터 철학을 구현할 것인지에 대한 경쟁으로 나아가고 있습니다. 이는 이제 '칩 성능'의 문제가 아니라 '모바일 AI 시대의 철학과 설계'라는 더 넓은 게임의 시작이라 할 수 있습니다.

📱 스마트폰, 이제는 'AI 생성 허브'로 진화 중

스마트폰은 더 이상 단순한 통신 기기가 아닙니다. 이미지 보정, 실시간 번역, 음성 인식부터 생성형 AI 기능까지, 사용자와 가장 가까운 위치에서 ‘생성’을 수행하는 작은 AI 센터로 탈바꿈하고 있습니다. 이런 흐름 속에서 SoC(System on Chip) 제조사들은 단순한 연산 성능 경쟁을 넘어서, 온디바이스 AI(On-device AI) 기능을 얼마나 효율적으로 탑재하고 차별화된 사용자 경험을 제공할 수 있을지를 중심으로 경쟁하고 있습니다.

데이터를 모두 클라우드에 보내 처리하던 기존 방식은 한계에 부딪혔습니다. 네트워크 지연, 개인정보 문제, 높은 에너지 소모, 클라우드 비용이 바로 그것입니다. 이에 따라, 각 기업은 자체 AI 칩셋(ASIC)을 통해 스마트폰 안에서 대부분의 AI 연산을 수행하려는 전략을 세우고 있습니다.

스마트폰은 이제 단순한 '통신 도구'의 정체성을 넘어, 실시간 생성형 인공지능(Generative AI)의 연산 허브로 거듭나고 있습니다. 과거에는 이미지 보정이나 음성 명령 처리가 서버에서 이루어졌다면, 오늘날에는 이 모든 일이 사용자의 손 안에서, 즉 기기 내부에서 실시간으로 수행됩니다.

이 변화는 사용자 기대의 변화와 기술 발전이라는 두 가지 축이 맞물린 결과입니다. 사용자들은 이제 AI 기능이 즉각적으로 반응하길 원합니다. 텍스트를 요약하거나, 음성을 텍스트로 변환하거나, 사진을 자동으로 보정하는 등의 기능이 인터넷 연결 없이도 자연스럽게 이뤄지는 경험을 기대하고 있습니다. 이러한 요구는 클라우드 기반 AI 처리 방식이 가진 구조적 한계 — 예를 들어 네트워크 지연(latency), 데이터 프라이버시 우려, 고비용 인프라, 에너지 비효율성 — 를 극명하게 드러내고 있습니다.

이에 따라 새로운 해답으로 부상한 것이 바로 **온디바이스 AI(On-device AI)**입니다. 이는 AI 연산을 스마트폰 자체에서 처리하는 방식으로, 사용자 경험을 획기적으로 개선할 수 있는 기술입니다. 클라우드를 거치지 않으므로 빠르고, 보안에 유리하며, 배터리 수명에도 긍정적 영향을 미칠 수 있습니다.

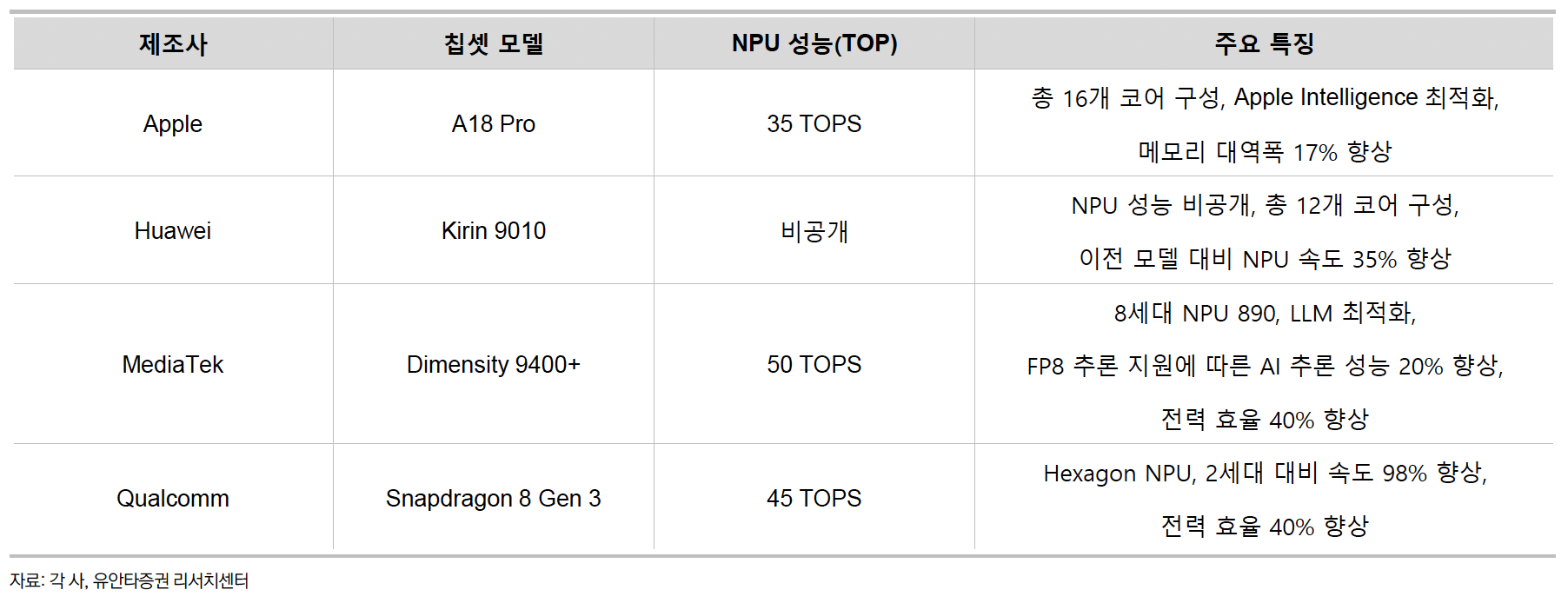

이러한 기술적 전환은 SoC(System on Chip) 설계의 패러다임을 바꾸고 있습니다. 기존의 CPU와 GPU 중심 구조를 넘어, NPU(Neural Processing Unit)라는 전용 AI 연산 유닛이 SoC에 통합되기 시작했고, 연산 성능과 전력 효율을 극대화하기 위한 메모리 아키텍처 최적화 및 고밀도 패키징 기술이 함께 발전하고 있습니다.

또한 생성형 AI 시대의 도래는 기존 AI 연산보다 훨씬 더 복잡하고 높은 자원을 요구합니다. 예를 들어, 대형 언어모델(LLM) 기반의 기능들은 실시간 텍스트 생성, 이미지 생성, 요약 및 번역을 가능하게 만들지만, 이는 단순한 분류나 예측을 넘는 연산 처리 능력을 요구합니다. 이를 감당하기 위해서는 단순히 칩의 성능을 높이는 것 이상으로, 메모리 지연을 줄이고, 전력 소모를 최적화하는 정교한 시스템 설계가 필수적입니다.

결과적으로 스마트폰은 더 이상 정보 소비의 '종착지'가 아닌, 지속적으로 정보를 생성하고 가공하는 창의적 연산의 출발점이 되고 있습니다. AI 기술의 대중화가 진행될수록, 우리는 스마트폰을 통해 자신만의 콘텐츠를 만들고, 정제하고, 의사결정을 내리는 주체로 더욱 자리매김하게 될 것입니다.

🍏 Apple: 프라이버시 중심의 하이브리드 전략

Apple은 이미 2017년 A11 Bionic 칩부터 Neural Engine을 탑재해 온디바이스 AI 시대를 가장 먼저 열었습니다. 얼굴 인식(Face ID), Siri의 오프라인 음성 명령, 사진 보정 등은 사용자 데이터를 기기 내에서 처리하여 빠르고 안전한 사용 경험을 제공합니다. 이는 Apple의 ‘프라이버시는 기본’이라는 철학을 반영한 것입니다.

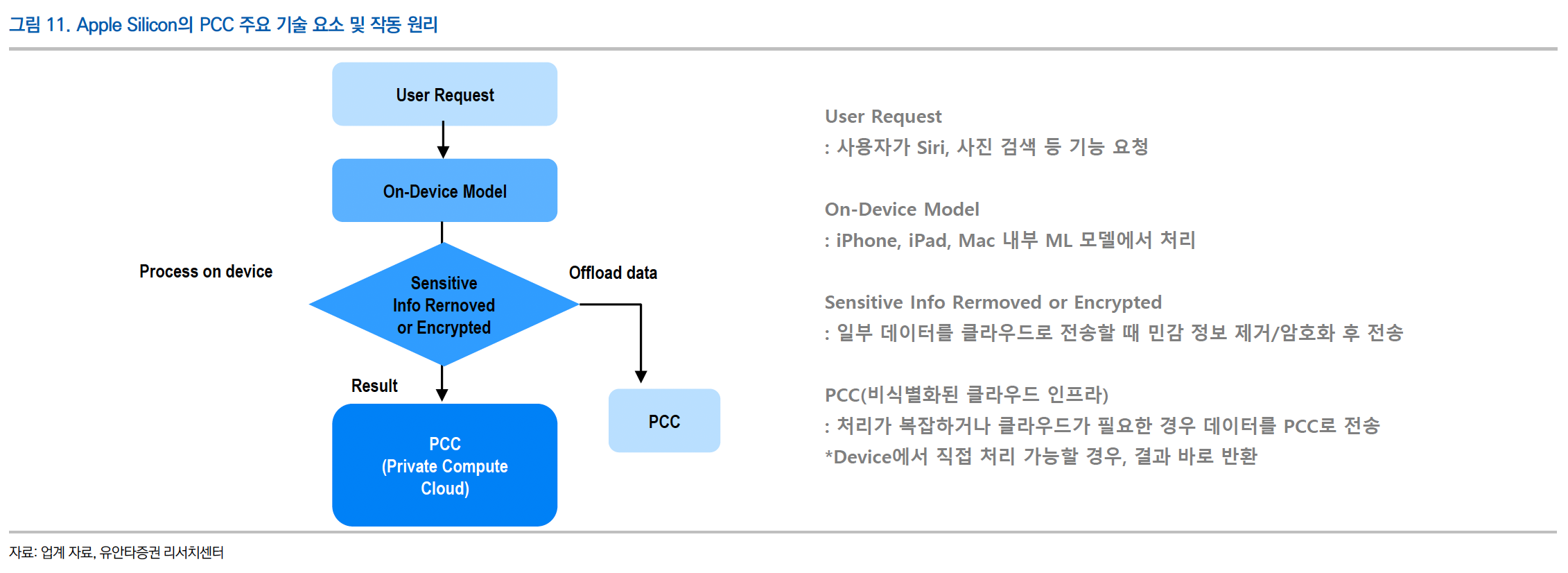

최근에는 iOS 18과 macOS 업데이트를 통해 Apple Silicon 기반 서버 인프라(PCC: Private Compute Cloud)와 연동하는 하이브리드 구조를 선보이고 있습니다. 민감 정보는 로컬에서 유지하고, 복잡한 연산만 서버로 전송하는 방식으로 프라이버시와 성능을 동시에 잡는 전략입니다. 칩부터 운영체제, 서버까지 완전히 통합된 Apple 생태계는 경쟁사들이 따라가기 어려운 고유의 구조로 자리잡고 있습니다.

Apple은 온디바이스 AI 경쟁에서 가장 일찍, 가장 일관된 철학으로 방향성을 제시한 기업입니다. 그 중심에는 '프라이버시 우선'이라는 확고한 신념이 자리하고 있습니다. 이 신념은 단지 슬로건이 아니라, 칩 설계에서 운영체제, 클라우드 인프라까지 일관되게 적용되는 Apple만의 AI 설계 철학입니다.

🔧 A11 Bionic과 Neural Engine: AI 스마트폰 시대의 서막

2017년 Apple이 발표한 A11 Bionic 칩은 스마트폰 역사에서 중요한 이정표였습니다. 이 칩에는 Apple이 자체 설계한 Neural Engine이 처음으로 탑재되었는데, 이는 AI 연산을 전담하는 전용 하드웨어 블록으로, 오늘날 스마트폰에 널리 탑재되는 NPU(Neural Processing Unit)의 선구자격 존재입니다. 당시 대부분의 안드로이드 스마트폰이 GPU나 DSP 기반의 AI 처리에 의존하던 것과 달리, Apple은 Facial Recognition(Face ID), 사진 보정, Siri의 오프라인 명령 처리 등 주요 기능을 기기 내에서 직접 처리하는 데 AI 연산을 활용했습니다.

Neural Engine은 CPU나 GPU에 비해 전력 효율이 훨씬 높으면서도, 복잡한 신경망 연산을 빠르게 수행할 수 있어 배터리 지속 시간과 반응 속도 모두를 잡을 수 있었습니다. 이로써 Apple은 단순한 기능 구현을 넘어서, 사용자 경험(UX) 전반에 AI를 녹여내는 데 성공했습니다.

🛡️ 프라이버시 중심 설계: 클라우드보다 로컬

Apple의 AI 전략은 **“데이터는 사용자 기기 안에서 처리되어야 한다”**는 철학에 기반합니다. 이는 단지 보안 향상 차원을 넘어, 기업의 브랜딩과 사용자 신뢰 구축의 핵심이기도 합니다. 예를 들어 Siri가 오프라인으로 명령을 처리하고, 사진 분류가 로컬에서 이루어지는 이유는 사용자의 데이터가 외부 서버로 전송되지 않도록 하기 위함입니다.

이러한 구조는 사용자에게 **데이터 주권(data sovereignty)**을 돌려주는 동시에, 애플리케이션이 네트워크 상태에 관계없이 일관된 성능을 제공할 수 있게 합니다.

☁️ PCC: AI 하이브리드 연산의 새로운 기준

Apple은 온디바이스 AI의 한계를 보완하기 위해 최근 **PCC(Private Compute Cloud)**라는 고유한 하이브리드 연산 구조를 도입했습니다. 이 구조는 복잡한 생성형 AI 연산(예: 텍스트 생성, 이미지 편집 등)이 필요한 경우, 데이터를 암호화된 상태로 자체 운영 서버로 전송하여 처리합니다. 중요한 점은 이 과정에서도 사용자의 민감한 정보는 로컬에 남기거나, 서버에 전송되더라도 완전히 익명화된 상태라는 것입니다.

이로써 Apple은 온디바이스 AI의 장점인 속도, 배터리 효율, 보안과 클라우드 AI의 복잡한 연산 처리 능력을 절묘하게 결합하는 데 성공했습니다. PCC는 iOS 18과 macOS의 차세대 기능들과 긴밀히 연동되며, Apple 생태계 안에서만 가능한 연산 최적화 모델을 구축하고 있습니다.

🧬 칩부터 서버까지 통합된 수직 생태계

Apple의 가장 큰 강점은 **칩 설계(Ax, Mx 시리즈), 운영체제(iOS, macOS), 클라우드 인프라(PCC)**를 모두 자사에서 통제하고 있다는 점입니다. 이러한 수직 통합은 경쟁사들이 모방하기 어려운 강력한 무기입니다. 클라우드 인프라가 외부에 의존적인 구글이나 삼성 등과 달리, Apple은 자체 데이터센터를 기반으로 프라이버시 중심의 AI 설계를 구현하고 있어, 기업의 브랜드 철학과 기술 전략이 완전히 일치하는 드문 사례로 평가받습니다.

🔮 미래 전략: 더 강력한 온디바이스 연산을 향해

Apple은 앞으로도 클라우드 의존도를 최소화하고, Bionic 칩의 NPU 연산 능력을 지속적으로 강화해 나갈 것으로 예상됩니다. 특히 생성형 AI가 더 많은 연산을 필요로 하게 되면서, 향후 iPhone과 iPad는 더욱 강력한 온디바이스 AI 기능을 갖추게 될 것입니다.

Apple의 전략은 단순한 기술력보다 한발 더 나아간, 철학 중심의 사용자 중심 설계라는 점에서 차별화됩니다. 그리고 이 차별화는 곧, Apple을 온디바이스 AI 경쟁에서 가장 앞선 위치로 끌어올리는 핵심 동력입니다.

📡 Huawei: 독자 기술로 완전한 온디바이스 AI 실현

미국의 제재로 Google과 ARM 생태계에서 벗어나야 했던 Huawei는 자립형 AI 전략을 채택했습니다. Kirin 칩셋과 자체 NPU 아키텍처인 Da Vinci를 기반으로 HarmonyOS 생태계를 구축하며 독립적인 AI 경험을 제공합니다.

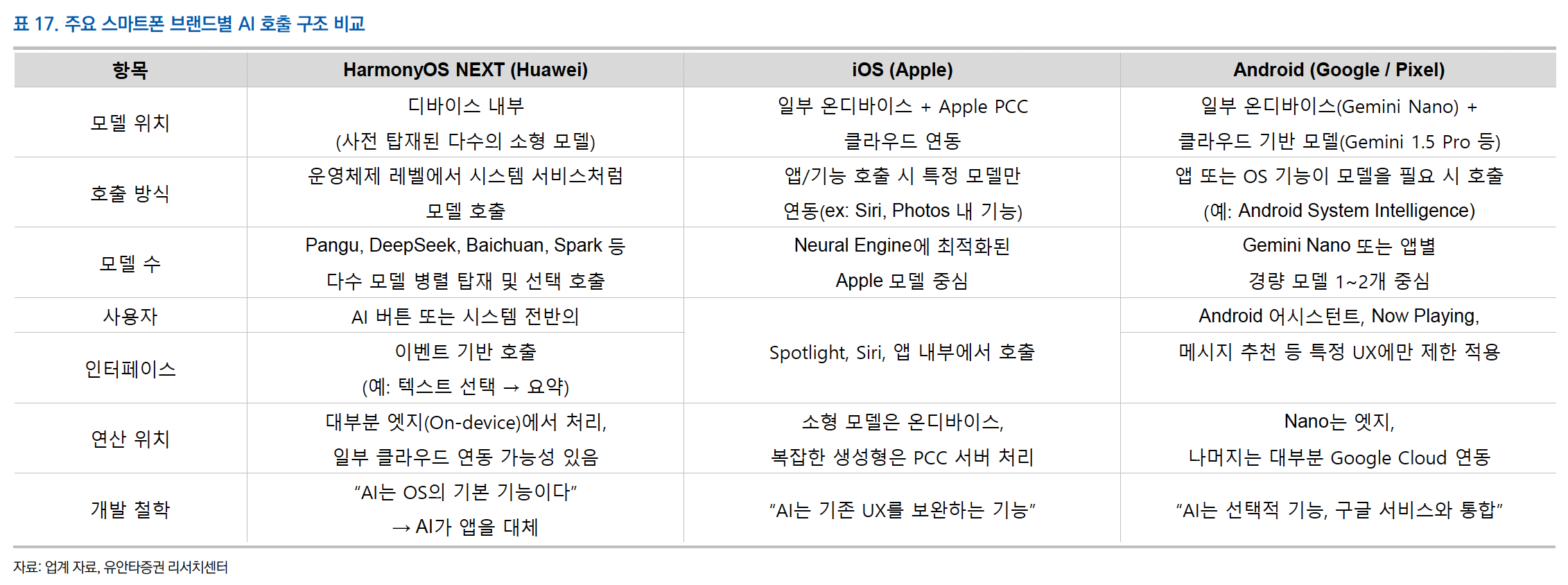

특히 HarmonyOS NEXT는 디바이스 내에 다양한 AI 모델(PanGu, Baichuan 등)을 탑재하고, AI 어시스턴트 버튼을 통해 상황에 맞는 모델을 자동 호출하는 구조를 갖추고 있습니다. 운영체제 수준에서 AI가 자연스럽게 개입하며 사용자 경험을 강화하는 방식은, 대부분의 연산을 기기 내에서 처리하려는 완전한 온디바이스 전략으로 주목받고 있습니다.

Huawei는 세계적인 기술 제재 속에서도 독자적인 AI 전략을 통해 온디바이스 AI 분야에서 가장 이상적인 구조를 실현하려는 시도를 이어가고 있습니다. 미국의 제재로 인해 Google의 Android 생태계와 ARM의 IP에 대한 접근이 제한된 상황에서, Huawei는 **자체 칩셋(Kirin 시리즈)**과 **자체 운영체제(HarmonyOS)**를 통해 하드웨어와 소프트웨어 모두를 독립적으로 구성하는 데 성공했습니다.

🧩 Kirin 칩셋과 Da Vinci 아키텍처: 제재를 넘어선 기술 자립

Huawei는 자사의 Kirin 칩셋에 독자적인 Da Vinci NPU 아키텍처를 탑재하여 AI 연산을 처리합니다. 이 NPU는 단순한 이미지 인식이나 음성 명령을 넘어, 텍스트 생성, 언어 번역, 콘텐츠 요약 같은 생성형 AI 기능을 스마트폰 내부에서 처리할 수 있는 수준으로 고도화되었습니다.

Da Vinci 아키텍처는 연산 병렬성, 전력 효율성, 실시간 처리 속도에서 우수한 성능을 발휘하며, 기존의 ARM 기반 NPU 구조보다 중국 내 AI 알고리즘 생태계에 최적화된 설계로 평가받고 있습니다. 이는 Huawei가 미국 의존 없이, 자체적으로 하드웨어 최적화를 할 수 있음을 보여주는 결정적 사례입니다.

🔁 HarmonyOS NEXT: AI와 OS의 완전한 융합

Huawei의 또 다른 핵심 경쟁력은 운영체제 차원에서 AI 기능을 구조적으로 통합했다는 점입니다. HarmonyOS NEXT는 단순한 앱 기반의 AI 기능 구현을 넘어서, 운영체제 내부에 AI 모델을 내장하고 이를 시스템 기능으로 호출하는 AI-내장형 OS 구조를 취하고 있습니다.

특히 AI 어시스턴트 버튼은 상황에 따라 디바이스에 탑재된 다양한 AI 모델 — PanGu, Baichuan, Spark 등 — 을 자동 호출하여 연산을 실행합니다. 이 방식은 사용자가 AI 기능을 '수동으로 실행'하는 것이 아니라, 시스템이 사용자의 상황과 요청을 판단하여 적절한 경량화 모델을 자동으로 선택·실행하는 구조입니다. 즉, AI가 사용자 경험의 배경에서 조용히 작동하는 ‘보이지 않는 파트너’로 기능하는 셈입니다.

🧠 전면적 온디바이스 전략: 클라우드 의존도 최소화

Huawei의 AI 전략은 Apple과는 대조적으로, 대부분의 AI 연산을 디바이스 내부에서 완결하려는 ‘로컬 중심 모델’입니다. 이는 네트워크 연결이 불안정하거나 외부 클라우드 접근이 제한적인 환경에서도 일관된 성능과 보안을 유지할 수 있는 장점을 갖습니다.

특히 중국 내 개인정보 보호 규제와 AI 관련 법제화 움직임에 따라, 사용자 데이터를 클라우드로 전송하지 않고 기기 내부에서 자체 처리하는 기술 구조는 Huawei가 정부와 시장 모두에 어필할 수 있는 전략적 무기가 되고 있습니다.

🔧 기술 생태계 자립과 차별화된 사용자 경험

Huawei는 하드웨어와 소프트웨어를 포함한 전체 기술 스택을 자립적으로 구축하고, AI를 이를 중심으로 재편하고 있습니다. 이는 단순히 기술 대체가 아니라, 중국 내 스마트폰 생태계의 독립성 확보와 국가적 기술 전략의 연장선으로도 해석됩니다.

또한 AI 기능을 앱처럼 외부에 ‘붙이는’ 것이 아닌, OS 수준에서 기능화함으로써, 사용자는 별도의 조작 없이도 더 직관적이고 유기적인 AI 경험을 누릴 수 있게 됩니다. 이는 Apple이나 Google보다 더 운영체제 차원의 통합이 깊은 구조로, AI가 마치 'OS의 본질'처럼 작동하는 환경을 지향합니다.

🔮 향후 전망: AI 스마트폰의 표준 모델을 제시할 수 있을까?

Huawei의 전략은 단기적으로는 중국 내 시장에서 큰 경쟁력을 가질 수 있으며, 장기적으로는 AI 스마트폰의 새로운 표준 모델을 제시할 가능성도 존재합니다. 글로벌 시장에서는 제재로 인해 Google 서비스를 사용할 수 없다는 한계가 있지만, 자국 시장에서의 완성도 높은 사용자 경험과 AI 기술력을 바탕으로 자체 생태계의 고도화를 지속해 나가고 있습니다.

요약하자면, Huawei는 ‘AI 기능의 하드웨어 내재화’와 ‘OS 레벨 통합’이라는 두 축을 기반으로 한 이상적인 온디바이스 AI 구조를 실현하려 하고 있으며, 이는 기술 자립과 동시에 사용자 중심 경험까지 아우르는 전략으로서 주목받고 있습니다.

🧠 Google: Tensor SoC와 LLM 내장 전략

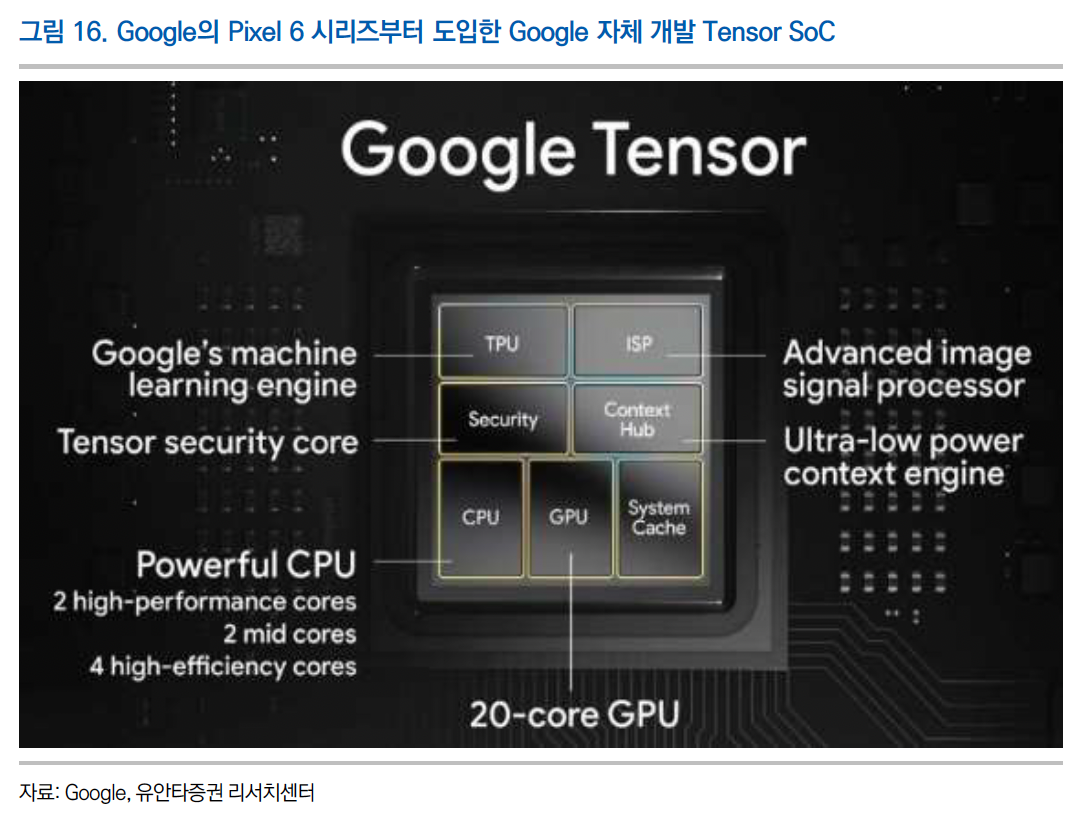

Google은 2021년 Pixel 6부터 자체 설계한 Tensor SoC를 탑재하며 AI 중심 전략으로 전환했습니다. 최근 Tensor G3에는 Google의 경량 LLM인 Gemini Nano가 통합되어, 생성형 AI 기능도 클라우드 없이 기기에서 바로 작동할 수 있게 되었습니다.

다가오는 Tensor G5는 TSMC에서 제조되며, Google이 직접 설계를 주도하는 완전한 커스텀 칩으로 예상됩니다. 이 칩은 서버용 TPU 기술을 모바일에도 이식하는 형태로, 클라우드와 디바이스의 AI 아키텍처 일관성을 확보하는 전략적 전환점이 될 전망입니다.

Google은 자사의 강력한 AI 서비스와 클라우드 인프라, 안드로이드 플랫폼을 결합하여 온디바이스 AI 전략을 다층적으로 전개하고 있는 기업입니다. 특히 2021년 출시한 Pixel 6부터 자체 설계한 **Tensor SoC(System on Chip)**를 탑재하며, 하드웨어까지 아우르는 AI 전략을 본격화했습니다. Google의 온디바이스 AI 전략은 단순한 성능 개선을 넘어서, **AI 중심 사용자 경험(UX)**을 실현하기 위한 근본적인 구조 전환으로 평가됩니다.

🔧 Tensor SoC: AI 최적화를 위한 커스텀 칩

Google의 첫 Tensor 칩셋(G1)은 삼성의 Exynos를 기반으로 Google이 자체 설계한 **AI 연산 블록(Edge TPU)**과 **이미지 신호 프로세서(ISP)**를 통합한 형태였습니다. 이는 기존에 클라우드에서 실행되던 기능들—예를 들어 실시간 음성 인식, 사진 자동 보정, 번역 기능—을 스마트폰 기기 내부에서 바로 수행할 수 있도록 설계되었습니다.

Tensor 칩은 이후 G2, G3로 발전하며 AI 연산 능력, 전력 효율, 멀티태스킹 최적화 측면에서 꾸준히 개선되어 왔으며, 특히 AI에 특화된 설계 구조 덕분에 Pixel 시리즈는 경쟁사보다 앞서 AI 기반 기능을 빠르게 상용화할 수 있었습니다.

🤖 Gemini Nano: 경량 LLM 내장으로 생성형 AI 본격화

Tensor G3 칩부터는 Google의 자체 대형 언어모델(LLM)인 Gemini의 경량 버전인 Gemini Nano가 본격적으로 연동되기 시작했습니다. 이는 클라우드 연결 없이도 기기 내에서 텍스트 생성, 요약, 문맥 이해 등 생성형 AI 기능을 수행할 수 있게 해주는 핵심 요소입니다.

예를 들어, 사용자는 Pixel 스마트폰에서 실시간으로 요약된 알림을 받거나, 입력 중인 문장을 자동 보완하는 **온디바이스 스마트 작성 기능(Smart Compose)**을 사용할 수 있습니다. 이 기능들은 모두 Gemini Nano가 Tensor NPU 위에서 작동함으로써, 프라이버시 보호와 지연 시간 단축이라는 두 마리 토끼를 동시에 잡습니다.

이러한 구조는 사용자 경험을 클라우드 의존 없이도 강화할 수 있는 중요한 전환점으로, Google의 스마트폰이 'AI를 쓰는 기기'를 넘어서 **'AI를 내장한 기기'**로 진화하고 있음을 보여줍니다.

🧬 Tensor G5와 TSMC: 완전한 커스텀 실리콘 전략

다가오는 Tensor G5부터는 Google이 직접 칩 설계를 주도하고, 제조 파트너도 삼성에서 TSMC로 전환될 예정입니다. 이는 단순한 성능 향상이 아니라, 칩 설계 전반을 Google이 통제하려는 의지를 나타냅니다. 특히 Tensor G5에는 서버용 AI 칩(TPU)의 경량화 버전이 통합될 것으로 예상되며, 모바일-클라우드 간 AI 아키텍처의 일관성 확보를 목표로 하고 있습니다.

Google은 이미 데이터센터에서 강력한 AI 연산을 지원하는 TPU(이하 Tensor Processing Unit) 인프라를 운영하고 있습니다. Tensor G5는 이러한 서버 기술을 스마트폰 수준으로 이식하는 전략적 시도이며, AI 성능, 에너지 효율, 데이터 처리 일관성을 모두 확보할 수 있는 구조적 전환점이 될 것입니다.

🌐 Google의 전략: 클라우드+온디바이스 AI의 결합

Google의 온디바이스 AI 전략은 Apple과 Huawei처럼 극단적인 로컬 중심, 혹은 프라이버시 위주의 설계와는 결이 조금 다릅니다. Google은 온디바이스 연산을 가능한 한 확대하면서도, 필요할 경우 Google Cloud와 원활하게 연동되는 클라우드-엣지 연계형 구조를 지향합니다.

이는 AI 연산의 경량화와 프라이버시 보호가 중요한 상황에서는 온디바이스 추론이 작동하고, 복잡한 생성 작업이 필요한 경우에는 Google 서버와 연동하는 하이브리드형 접근 방식입니다. 이러한 구조는 클라우드 기반의 강력한 LLM 생태계(Gemini), Android OS의 대규모 배포력, 그리고 Pixel 하드웨어의 통합을 통해 구현됩니다.

🧭 Android 생태계 확장: 표준화의 신호탄

Google은 향후 Tensor SoC 및 AI 가속기 기술을 Pixel 시리즈에만 한정하지 않고, Android 생태계 전체로 확산시키려는 전략을 취할 가능성이 큽니다. 예를 들어 Tensor에서 사용된 Edge TPU 아키텍처나 Gemini Nano 연동 기술을 Android 표준 API로 공개함으로써, 삼성, Xiaomi, Oppo 등 다른 제조사들도 비슷한 AI 경험을 구현할 수 있도록 지원할 수 있습니다.

이는 Google이 단순한 하드웨어 제조사를 넘어, AI 중심 스마트폰 플랫폼의 설계자로 자리잡고자 하는 전략의 일환이며, Android의 미래 경쟁력을 강화하는 핵심 요소가 될 것입니다.

⚙️ Qualcomm & MediaTek: 다양한 디바이스를 위한 범용 솔루션

Qualcomm은 Hexagon NPU 기반의 범용 AI 플랫폼을 제공하여 다양한 OEM이 유연하게 AI 기능을 구현할 수 있게 합니다. 차량용 Snapdragon Ride 플랫폼에도 동일한 저전력 설계 철학을 적용하며, 확장성과 에너지 효율 모두를 만족시키고 있습니다.

MediaTek은 Dimensity 시리즈를 통해 중가형부터 프리미엄 스마트폰까지 아우르며 저전력 기반의 온디바이스 AI 기능을 강화하고 있습니다. 특히, 오프라인 상태에서도 작동하는 경량 LLM이나 이미지 인식 기능은 미디어텍이 지닌 강점을 잘 보여줍니다.

온디바이스 AI의 대중화는 프리미엄 스마트폰뿐 아니라 중저가 모델, 웨어러블, 자동차, IoT 디바이스 등 다양한 하드웨어 플랫폼에서의 구현 가능성까지 확장되고 있습니다. 이러한 요구에 부응하는 대표적인 기업이 바로 Qualcomm과 MediaTek입니다. 두 회사는 다양한 제조사가 손쉽게 온디바이스 AI 기능을 구현할 수 있도록 범용성과 유연성을 겸비한 솔루션을 제공합니다.

🔩 Qualcomm: 저전력 AI 설계의 선두주자

Qualcomm은 전통적으로 모바일 칩셋의 저전력 설계에 강점을 가져왔으며, 이러한 특성은 온디바이스 AI 구현에 최적화된 조건을 제공합니다. 대표 제품군인 Snapdragon 시리즈에는 **Hexagon NPU(Neural Processing Unit)**가 탑재되어, 음성 인식, 이미지 보정, 카메라 자동 초점, 실시간 번역 등의 기능을 높은 에너지 효율로 수행할 수 있도록 지원합니다.

Qualcomm의 AI 엔진은 단일 연산 유닛에 의존하지 않고, CPU, GPU, NPU, DSP를 통합하여 워크로드에 따라 동적으로 연산 자원을 분배합니다. 이러한 **멀티코어 이종 연산 구조(Heterogeneous Computing Architecture)**는 다양한 디바이스와 애플리케이션에서 유연하게 적용될 수 있으며, OEM 제조사 입장에서는 커스터마이징이 용이하다는 이점을 가집니다.

특히 Snapdragon Ride 플랫폼은 차량용 칩셋에서도 AI를 활용한 자율주행, 시각 인식, 음성 명령 처리를 가능하게 합니다. 이처럼 Qualcomm은 모바일에서 축적한 AI 기술을 **전장(자동차)**과 산업용 IoT까지 확장하며, 광범위한 AI 생태계를 구축하고 있습니다.

🛠️ MediaTek: 효율성과 접근성을 모두 잡은 전략

MediaTek은 Dimensity 시리즈를 중심으로 프리미엄 및 중가형 스마트폰 시장에서의 AI 확산을 주도하고 있습니다. 특히 AI 연산의 저전력화, 경량화된 LLM 추론 구조, 통합 이미지 처리 기술을 통해 오프라인 기반의 AI 경험을 제공하는 데 주력하고 있습니다.

MediaTek의 **APU(AI Processing Unit)**는 주로 이미지 및 영상 처리에 특화되어 있으며, 실시간 얼굴 인식, 객체 추적, 배경 제거, 음성 명령 처리 등 다양한 기능을 효율적으로 수행합니다. 또한, 최신 Dimensity 칩셋에서는 경량 LLM(예: GPT 기반 모델)의 온디바이스 추론 기능이 탑재되며, 생성형 AI의 기기 내 구동이 가능한 환경을 만들어가고 있습니다.

중국, 동남아, 인도 등 빠르게 성장하는 신흥 시장에서의 보급형 AI폰 수요에 발맞춰, MediaTek은 고가 하드웨어 없이도 AI 기능을 사용할 수 있도록 접근성을 높이고 있다는 평가를 받습니다.

🧰 하드웨어만이 아니다: 툴킷과 소프트웨어 생태계

Qualcomm과 MediaTek 모두 단순히 칩을 공급하는 수준을 넘어서, **AI 툴킷과 SDK(Software Development Kit)**를 함께 제공하여 OEM이 자신만의 AI 기능을 개발하고 최적화할 수 있도록 지원하고 있습니다.

- Qualcomm AI Stack: Hexagon SDK, AI Model Efficiency Toolkit(AIMET), ONNX 지원, TensorFlow Lite 통합 등 다양한 프레임워크를 통한 개발 환경 제공

- MediaTek NeuroPilot: TensorFlow, Caffe, ONNX 등을 지원하며, Android NN API와도 연동 가능한 유연한 툴킷 제공

이를 통해 다양한 디바이스 제조사들이 자사 제품에 맞는 AI 기능을 설계하고, Edge 단에서의 추론을 구현할 수 있는 범용 플랫폼 역할을 수행하고 있습니다.

🔮 온디바이스 AI의 대중화를 향해

Qualcomm과 MediaTek은 기술 철학과 비즈니스 전략에서는 Apple, Google, Huawei처럼 자사 생태계를 통제하거나 프리미엄 기기에 집중하기보다는, 보다 폭넓은 제조사들과의 협력, 다양한 디바이스 유형에의 확산, 표준화된 플랫폼 제공을 통해 온디바이스 AI의 대중화를 주도하고 있습니다.

이들 기업의 전략은 ‘하나의 최상위 AI 경험’을 제공하려는 접근이 아니라, ‘다양한 현실 조건에서 가장 적합한 AI 경험’을 구현하는 플랫폼 전략으로 요약할 수 있습니다. 이는 스마트폰뿐 아니라 웨어러블, 차량, 스마트 가전, IoT 장비에 이르기까지 모든 전자 디바이스에 AI를 이식할 수 있는 기반 기술로서의 가치를 의미합니다.

🔩 온디바이스 AI를 위한 하드웨어 진화

온디바이스 AI는 단순한 AI 칩만으로는 완성되지 않습니다. 연산 유닛과 가까운 위치에 고속 메모리(SRAM 등)를 배치하여 지연을 최소화하는 메모리 아키텍처, 그리고 다이 간 연결을 최적화한 **첨단 패키징 기술(PLP, SoIC)**이 함께 발전하고 있습니다. 이처럼 반도체 설계, 메모리 구조, 패키징 기술의 전방위적인 혁신이 AI 스마트폰 경쟁을 견인하고 있습니다.

온디바이스 AI가 본격적으로 구현되기 위해서는 단순히 NPU(Neural Processing Unit)를 칩에 추가하는 수준을 넘어, SoC 전체 구조와 메모리, 패키징, 전력 설계에 이르기까지 전방위적인 하드웨어 혁신이 필요합니다. 생성형 AI가 요구하는 연산은 기존의 모바일 애플리케이션에 비해 훨씬 더 크고 복잡한 계산량을 수반하기 때문에, 이를 효율적으로 수행하기 위한 하드웨어 진화는 온디바이스 AI 경쟁의 핵심 동력이라 할 수 있습니다.

🧠 NPU 중심 SoC 아키텍처로의 전환

기존 모바일 SoC는 CPU와 GPU 중심의 연산 구조였습니다. 그러나 AI 연산, 특히 신경망 추론(Neural Network Inference)은 이러한 범용 연산 유닛보다는, AI에 특화된 병렬 처리 유닛인 NPU가 훨씬 높은 전력 효율과 성능을 발휘합니다.

최근의 프리미엄 스마트폰 SoC들은 대부분 NPU 또는 APU(AI Processing Unit)를 내장하고 있으며, 이들은 이미지/영상 인식, 음성 명령 처리, 자연어 이해, 번역, 요약, 생성 등의 기능을 실시간으로 수행합니다. AI 연산량이 기하급수적으로 증가함에 따라, 단순한 NPU의 탑재를 넘어서, SoC 자체를 AI 연산 중심 구조로 재설계하는 추세가 가속화되고 있습니다.

💾 메모리 아키텍처의 혁신: SRAM과 연산 근접 메모리

온디바이스 AI 연산에서 병목 현상이 발생하는 주요 지점은 ‘메모리 접근 시간’입니다. 전통적인 DRAM은 고속 연산을 따라가기 어려운 지연(latency) 문제와, 더불어 전력 소모가 큰 구조라는 단점을 갖고 있습니다.

이에 따라 최근에는 **SRAM(Static RAM)**을 연산 유닛 가까이에 배치하여 마치 ‘L1 캐시처럼’ 작동하게 하는 **근접 메모리 설계(Local memory, Near-memory computing)**가 주목받고 있습니다. 이러한 설계는 NPU가 필요한 데이터에 지연 없이 접근할 수 있게 하여, 전체적인 AI 연산 속도와 에너지 효율을 대폭 개선합니다.

특히 생성형 AI 모델이 실시간으로 텍스트를 생성하거나 이미지 변환을 수행할 때는 수천~수만 개의 파라미터에 대한 반복 연산이 발생하므로, 메모리 접근 속도 자체가 AI 체감 성능에 직결됩니다.

🧱 첨단 패키징 기술: PLP, SoIC, 2.5D·3D IC

칩 내부뿐 아니라 칩 외부 구성 방식, 즉 패키징 기술(Packaging Technology) 역시 온디바이스 AI 성능에 결정적인 역할을 합니다. 특히 최근 AI 칩 설계에서 주목받는 기술은 다음과 같습니다:

- PLP(Panel Level Packaging): 웨이퍼가 아닌 패널 단위로 패키징하여 고밀도 집적과 비용 절감을 동시에 추구하는 방식.

- SoIC(System on Integrated Chip): 서로 다른 칩 다이를 수직으로 적층(3D)하여 면적을 줄이고, 신호 지연을 최소화하는 첨단 기술.

- 2.5D/3D IC: 여러 다이(die)를 실리콘 인터포저나 적층 구조로 연결하여 연산 유닛, 메모리, 인터페이스를 물리적으로 인접하게 배치함으로써 AI 연산 간의 데이터 이동 거리를 최소화하고, 열 확산 효율을 극대화.

이러한 첨단 패키징 기술은 단순히 칩을 작게 만드는 것이 아니라, AI 성능을 극적으로 끌어올리는 구조적 해법으로, TSMC, 삼성, Intel 등 선도 파운드리 기업들이 모두 이 영역에 집중 투자하고 있습니다.

🔋 전력 설계 및 열 관리 기술의 중요성

AI 연산은 전력 소모가 크고 발열이 심하기 때문에, 온디바이스 AI를 실현하려면 저전력 설계와 고효율 냉각 시스템이 필수입니다. 이를 위해 제조사들은 전력 소모가 많은 연산은 가능한 한 NPU나 APU에서 수행하고, 불필요한 코어의 전원을 꺼두는 동적 전력 관리(Dynamic Power Management) 기술을 적극 활용합니다.

또한 최근에는 스마트폰 내부 공간을 고려해 증기 챔버(Vapor Chamber), 그래핀 시트, 냉각 파이프 등 고성능 열 확산 장치를 내장하는 기기도 늘고 있습니다. 이는 단순히 하드웨어 안정성을 높이는 것뿐 아니라, AI 기능이 장시간 안정적으로 동작할 수 있는 기반을 제공한다는 점에서 중요합니다.

🧭 온디바이스 AI 성능의 핵심은 ‘통합적 설계’

온디바이스 AI는 단순히 ‘칩이 빠르다’는 수준의 경쟁이 아닙니다. 진정한 경쟁력은 AI 연산 유닛, 메모리, 패키징, 전력, 냉각, OS 연계, AI 프레임워크 등 모든 요소가 하나의 통합된 시스템으로 동작할 때 발휘됩니다.

Apple, Google, Huawei와 같은 기업들이 자체 칩 설계부터 운영체제, AI 서비스까지 통합하고 있는 이유도 바로 여기에 있습니다. Qualcomm, MediaTek은 다양한 OEM을 지원하기 위해 범용적인 설계와 툴킷을 제공하면서, 동일한 방향성을 기술적으로 구현하고 있습니다.

결국, 온디바이스 AI의 진화는 곧 하드웨어 설계 철학의 진화이며, 이 변화는 AI가 우리 일상 속에서 ‘더 가까이, 더 빠르게, 더 효율적으로’ 작동하게 만드는 핵심 기반이 됩니다.

🧭 결론: AI 철학의 차이가 사용자 경험을 바꾼다

온디바이스 AI 도입 경쟁은 단순한 성능 경쟁이 아닙니다. 각 기업은 프라이버시, 독립 생태계, 생성형 AI의 로컬화, 범용 플랫폼 제공 등 각자의 철학과 목표에 따라 차별화된 아키텍처와 전략을 펼치고 있습니다. 이 경쟁은 스마트폰의 본질을 바꾸는 혁신이며, 앞으로 어떤 기업의 접근 방식이 시장에서 더욱 사랑받을지 지켜볼 일입니다.

온디바이스 AI 경쟁은 더 이상 특정 기업만의 차별화 수단이 아닙니다. 그것은 지금 이 순간도 모든 스마트폰 사용자 경험의 근본 구조를 바꾸고 있는 산업적 전환이며, 동시에 각 기업의 전략과 철학이 정면으로 드러나는 무대입니다.

Apple은 프라이버시와 UX 최적화를 최우선 가치로 삼아 칩, OS, 서버까지 유기적으로 통합한 하이브리드형 분산 AI 연산 모델을 제시하고 있으며, Huawei는 외부 생태계에 의존하지 않는 완전한 온디바이스 자립형 AI 구조를 통해 독자 노선을 걷고 있습니다. Google은 클라우드 AI의 최강자답게 모바일-클라우드 연산의 일관성을 확보하는 구조를 구상하고 있고, Qualcomm과 MediaTek은 보다 많은 제조사들이 손쉽게 AI 기능을 구현할 수 있도록 범용 플랫폼과 저전력 설계에 집중하고 있습니다.

이처럼 각 기업은 자사의 기술적 강점과 서비스 철학에 따라 서로 다른 온디바이스 AI 전략을 펼치고 있으며, 이 전략은 단지 스마트폰의 성능을 넘어, 사용자가 AI를 어떻게 받아들이고 활용하게 될지를 결정짓는 핵심 요인이 됩니다.

앞으로 생성형 AI는 더욱 복잡해지고, 사용자들은 더 높은 수준의 즉시성과 보안, 개인화를 요구할 것입니다. 이러한 흐름 속에서 승자는 단순히 빠른 칩을 만든 기업이 아니라, AI와 인간의 관계를 가장 유기적이고 직관적으로 설계한 기업이 될 것입니다. 그리고 바로 지금, 그 경쟁은 이미 스마트폰 속에서 치열하게 진행되고 있습니다.

'배움: MBA, English, 운동' 카테고리의 다른 글

| 🚀 Nvidia, 중국 없이도 질주 중! (66) | 2025.05.31 |

|---|---|

| 🚀 AI 시대, 컴퓨팅 아키텍처의 대전환과 반도체 산업의 재편 (28) | 2025.05.31 |

| ✈️ 캘리포니아 인구를 떠받치는 유일한 힘: '이민' (36) | 2025.05.30 |

| ⚖️ 트럼프의 '글로벌 관세' 제동 걸리다! – 무역법원 판결의 의미는? (45) | 2025.05.29 |

| 🍏 팀 쿡의 고난의 행군, 애플의 위기 2025년 📉 (45) | 2025.05.29 |